diff --git a/chapters/rum/_toctree.yml b/chapters/rum/_toctree.yml

index f25c69af5..7ce8f28cd 100644

--- a/chapters/rum/_toctree.yml

+++ b/chapters/rum/_toctree.yml

@@ -211,3 +211,51 @@

title: Quiz de final de capitol

quiz: 10

+- title: 11. Fine-tuning pentru modele mari de limbaj

+ subtitle: Folosiți fine-tuningul supervizat și adaptarea de rang scăzut pentru a ajusta fin un model mare de limbaj

+ sections:

+ - local: chapter11/1

+ title: Introducere

+ - local: chapter11/2

+ title: Template-uri de chat

+ - local: chapter11/3

+ title: Fine-tuning cu SFTTrainer

+ - local: chapter11/4

+ title: LoRA (Adaptarea de rang scăzut)

+ - local: chapter11/5

+ title: Evaluarea

+ - local: chapter11/6

+ title: Concluzie

+ - local: chapter11/7

+ title: E timpul examenului!

+ quiz: 11

+

+- title: 12. Construiește Modele de Raționament

+ subtitle: Învață cum să construiești modele de raționament precum DeepSeek R1

+ new: true

+ sections:

+ - local: chapter12/1

+ title: Introducere

+ - local: chapter12/2

+ title: Învățarea prin Întărire pe LLM-uri

+ - local: chapter12/3

+ title: Momentul Aha în Lucrarea DeepSeek R1

+ - local: chapter12/3a

+ title: Înțelegerea Avansată a GRPO în DeepSeekMath

+ - local: chapter12/4

+ title: Implementarea GRPO în TRL

+ - local: chapter12/5

+ title: Exercițiu Practic pentru Ajustarea Fină a unui Model cu GRPO

+ - local: chapter12/6

+ title: Exercițiu Practic cu Unsloth

+ - local: chapter12/7

+ title: În curând...

+

+- title: Evenimente Curs

+ sections:

+ - local: events/1

+ title: Sesiuni live și workshop-uri

+ - local: events/2

+ title: Evenimentul de lansare a părții 2

+ - local: events/3

+ title: Petrecerea Gradio Blocks

diff --git a/chapters/rum/chapter11/1.mdx b/chapters/rum/chapter11/1.mdx

new file mode 100644

index 000000000..967010bab

--- /dev/null

+++ b/chapters/rum/chapter11/1.mdx

@@ -0,0 +1,33 @@

+# Fine-tuning supervizat

+

+În [Capitolul 2 Secțiunea 2](/course/chapter2/2), am văzut că modelele de limbaj generativ pot fi ajustate pentru sarcini specifice, cum ar fi rezumarea și răspunsul la întrebări. Cu toate acestea, în zilele noastre este mult mai frecvent să ajustăm modelele de limbaj pe o gamă largă de sarcini simultan; o metodă cunoscută sub numele de fine-tuning supervizat (SFT). Acest proces ajută modelele să devină mai versatile și capabile să gestioneze diverse cazuri de utilizare. Majoritatea LLM-urilor cu care oamenii interacționează pe platforme precum ChatGPT au trecut prin SFT pentru a fi mai utile și aliniate cu preferințele umane. Vom împărți acest capitol în patru secțiuni:

+

+## 1️⃣ Template-uri de chat

+

+Template-urile de chat structurează interacțiunile dintre utilizatori și modelele AI, asigurând răspunsuri consecvente și adecvate contextual. Acestea includ componente precum prompturi de sistem și mesaje bazate pe roluri.

+

+## 2️⃣ Fine-tuning supervizat

+

+Fine-tuningul supervizat (SFT) este un proces critic pentru adaptarea modelelor de limbaj pre-antrenate la sarcini specifice. Aceasta implică antrenarea modelului pe un set de date specific sarcinii cu exemple etichetate. Pentru un ghid detaliat despre SFT, inclusiv pașii cheie și cele mai bune practici, consultați [secțiunea de fine-tuning supervizat din documentația TRL](https://huggingface.co/docs/trl/en/sft_trainer).

+

+## 3️⃣ Adaptarea de rang scăzut (LoRA)

+

+Adaptarea de rang scăzut (LoRA) este o tehnică pentru fine-tuningul modelelor de limbaj prin adăugarea de matrice de rang scăzut la straturile modelului. Aceasta permite un fine-tuning eficient păstrând în același timp cunoștințele pre-antrenate ale modelului. Unul dintre beneficiile cheie ale LoRA este economia semnificativă de memorie pe care o oferă, făcând posibilă ajustarea modelelor mari pe hardware cu resurse limitate.

+

+## 4️⃣ Evaluarea

+

+Evaluarea este un pas crucial în procesul de fine-tuning. Ne permite să măsurăm performanța modelului pe un set de date specific sarcinii.

+

+

+⚠️ Pentru a beneficia de toate funcționalitățile disponibile cu Model Hub și 🤗 Transformers, recomandăm crearea unui cont.

+

+

+## Referințe

+

+- [Documentația Transformers despre template-urile de chat](https://huggingface.co/docs/transformers/main/en/chat_templating)

+- [Script pentru fine-tuning supervizat în TRL](https://github.com/huggingface/trl/blob/main/trl/scripts/sft.py)

+- [`SFTTrainer` în TRL](https://huggingface.co/docs/trl/main/en/sft_trainer)

+- [Lucrarea despre optimizarea directă a preferințelor](https://arxiv.org/abs/2305.18290)

+- [Fine-tuning supervizat cu TRL](https://huggingface.co/docs/trl/sft_trainer)

+- [Cum să faceți fine-tuning la Google Gemma cu ChatML și Hugging Face TRL](https://github.com/huggingface/alignment-handbook)

+- [Fine-tuning LLM pentru a genera cataloage de produse persane în format JSON](https://huggingface.co/learn/cookbook/en/fine_tuning_llm_to_generate_persian_product_catalogs_in_json_format)

\ No newline at end of file

diff --git a/chapters/rum/chapter11/2.mdx b/chapters/rum/chapter11/2.mdx

new file mode 100644

index 000000000..b5fe8d46a

--- /dev/null

+++ b/chapters/rum/chapter11/2.mdx

@@ -0,0 +1,253 @@

+

+

+# Template-uri de chat

+

+## Introducere

+

+Template-urile de chat sunt esențiale pentru structurarea interacțiunilor dintre modelele de limbaj și utilizatori. Indiferent dacă construiți un chatbot simplu sau un agent AI complex, înțelegerea modului de a formata corect conversațiile este crucială pentru a obține cele mai bune rezultate de la modelul dumneavoastră. În acest ghid, vom explora ce sunt template-urile de chat, de ce sunt importante și cum să le folosiți eficient.

+

+

+Template-urile de chat sunt cruciale pentru:

+- Menținerea unei structuri consecvente de conversație

+- Asigurarea identificării corecte a rolurilor

+- Gestionarea contextului pe mai multe tururi

+- Suportarea funcționalităților avansate precum utilizarea instrumentelor

+

+

+## Tipuri de modele și template-uri

+

+### Modele de bază versus modele instruct

+Un model de bază este antrenat pe date text brute pentru a prezice următorul token, în timp ce un model instruct este ajustat specific pentru a urma instrucțiuni și a se angaja în conversații. De exemplu, [`SmolLM2-135M`](https://huggingface.co/HuggingFaceTB/SmolLM2-135M) este un model de bază, în timp ce [`SmolLM2-135M-Instruct`](https://huggingface.co/HuggingFaceTB/SmolLM2-135M-Instruct) este varianta sa ajustată pentru instrucțiuni.

+

+Modelele ajustate pentru instrucțiuni sunt antrenate să urmeze o structură conversațională specifică, făcându-le mai potrivite pentru aplicații de chatbot. Mai mult, modelele instruct pot gestiona interacțiuni complexe, inclusiv utilizarea instrumentelor, intrări multimodale și apeluri de funcții.

+

+Pentru a face ca un model de bază să se comporte ca un model instruct, trebuie să formatăm prompturile într-un mod consecvent pe care modelul să îl înțeleagă. Aici intervin template-urile de chat. ChatML este unul dintre aceste formate de template care structurează conversațiile cu indicatori clari de rol (sistem, utilizator, asistent). Iată un ghid despre [ChatML](https://huggingface.co/HuggingFaceTB/SmolLM2-135M-Instruct/blob/e2c3f7557efbdec707ae3a336371d169783f1da1/tokenizer_config.json#L146).

+

+

+Când folosiți un model instruct, verificați întotdeauna că folosiți formatul corect de template de chat. Folosirea unui template greșit poate duce la performanțe slabe ale modelului sau comportament neașteptat. Cea mai ușoară modalitate de a vă asigura de acest lucru este să verificați configurația tokenizer-ului modelului pe Hub. De exemplu, modelul `SmolLM2-135M-Instruct` folosește această configurație.

+

+

+### Formate comune de template

+

+Înainte de a aprofunda implementări specifice, este important să înțelegem cum diferite modele se așteaptă ca conversațiile lor să fie formatate. Să explorăm câteva formate comune de template folosind un exemplu simplu de conversație:

+

+Vom folosi următoarea structură de conversație pentru toate exemplele:

+

+```python

+messages = [

+ {"role": "system", "content": "You are a helpful assistant."},

+ {"role": "user", "content": "Hello!"},

+ {"role": "assistant", "content": "Hi! How can I help you today?"},

+ {"role": "user", "content": "What's the weather?"},

+]

+```

+

+Acesta este template-ul ChatML folosit în modele precum SmolLM2 și Qwen 2:

+

+```sh

+<|im_start|>system

+You are a helpful assistant.<|im_end|>

+<|im_start|>user

+Hello!<|im_end|>

+<|im_start|>assistant

+Hi! How can I help you today?<|im_end|>

+<|im_start|>user

+What's the weather?<|im_start|>assistant

+```

+

+Acesta folosește formatul de template `mistral`:

+

+```sh

+[INST] You are a helpful assistant. [/INST]

+Hi! How can I help you today?

+[INST] Hello! [/INST]

+```

+

+Diferențele cheie între aceste formate includ:

+1. **Gestionarea mesajelor de sistem**:

+ - Llama 2 înfășoară mesajele de sistem în etichete `<>`

+ - Llama 3 folosește etichete `<|system|>` cu încheierea ``

+ - Mistral include mesajul de sistem în prima instrucțiune

+ - Qwen folosește rolul explicit `system` cu etichete `<|im_start|>`

+ - ChatGPT folosește prefixul `SYSTEM:`

+

+2. **Granițele mesajelor**:

+ - Llama 2 folosește etichete `[INST]` și `[/INST]`

+ - Llama 3 folosește etichete specifice rolurilor (`<|system|>`, `<|user|>`, `<|assistant|>`) cu încheierea ``

+ - Mistral folosește `[INST]` și `[/INST]` cu `` și ``

+ - Qwen folosește token-uri de start/sfârșit specifice rolurilor

+

+3. **Token-uri speciale**:

+ - Llama 2 folosește `` și `` pentru granițele conversației

+ - Llama 3 folosește `` pentru a încheia fiecare mesaj

+ - Mistral folosește `` și `` pentru granițele turului

+ - Qwen folosește token-uri de start/sfârșit specifice rolurilor

+

+Înțelegerea acestor diferențe este cheia pentru a lucra cu modele variate. Să vedem cum biblioteca transformers ne ajută să gestionăm aceste variații automat:

+

+```python

+from transformers import AutoTokenizer

+

+# Acestea vor folosi template-uri diferite automat

+mistral_tokenizer = AutoTokenizer.from_pretrained("mistralai/Mistral-7B-Instruct-v0.1")

+qwen_tokenizer = AutoTokenizer.from_pretrained("Qwen/Qwen-7B-Chat")

+smol_tokenizer = AutoTokenizer.from_pretrained("HuggingFaceTB/SmolLM2-135M-Instruct")

+

+messages = [

+ {"role": "system", "content": "You are a helpful assistant."},

+ {"role": "user", "content": "Hello!"},

+]

+

+# Fiecare va formata conform template-ului modelului său

+mistral_chat = mistral_tokenizer.apply_chat_template(messages, tokenize=False)

+qwen_chat = qwen_tokenizer.apply_chat_template(messages, tokenize=False)

+smol_chat = smol_tokenizer.apply_chat_template(messages, tokenize=False)

+```

+

+

+Faceți clic pentru a vedea exemplele de template

+

+Template ChatML pentru Qwen 2 și SmolLM2:

+

+```sh

+<|im_start|>system

+You are a helpful assistant.<|im_end|>

+<|im_start|>user

+Hello!<|im_end|>

+<|im_start|>assistant

+Hi! How can I help you today?<|im_end|>

+<|im_start|>user

+What's the weather?<|im_start|>assistant

+```

+

+Template Mistral:

+

+```sh

+[INST] You are a helpful assistant. [/INST]

+Hi! How can I help you today?

+[INST] Hello! [/INST]

+```

+

+

+

+### Funcționalități avansate

+Template-urile de chat pot gestiona scenarii mai complexe dincolo de simpla interacțiune conversațională, inclusiv:

+

+1. **Utilizarea instrumentelor**: Când modelele trebuie să interacționeze cu instrumente externe sau API-uri

+2. **Intrări multimodale**: Pentru gestionarea imaginilor, audio sau alte tipuri de media

+3. **Apeluri de funcții**: Pentru executarea structurată de funcții

+4. **Context multi-turn**: Pentru menținerea istoricului conversației

+

+

+Când implementați funcționalități avansate:

+- Testați temeinic cu modelul dumneavoastră specific. Template-urile de viziune și utilizare a instrumentelor sunt deosebit de diverse.

+- Monitorizați cu atenție utilizarea token-urilor între fiecare funcționalitate și model.

+- Documentați formatul așteptat pentru fiecare funcționalitate

+

+

+Pentru conversații multimodale, template-urile de chat pot include referințe la imagini sau imagini codificate în base64:

+

+```python

+messages = [

+ {

+ "role": "system",

+ "content": "You are a helpful vision assistant that can analyze images.",

+ },

+ {

+ "role": "user",

+ "content": [

+ {"type": "text", "text": "What's in this image?"},

+ {"type": "image", "image_url": "https://example.com/image.jpg"},

+ ],

+ },

+]

+```

+

+Iată un exemplu de template de chat cu utilizarea instrumentelor:

+

+```python

+messages = [

+ {

+ "role": "system",

+ "content": "You are an AI assistant that can use tools. Available tools: calculator, weather_api",

+ },

+ {"role": "user", "content": "What's 123 * 456 and is it raining in Paris?"},

+ {

+ "role": "assistant",

+ "content": "Let me help you with that.",

+ "tool_calls": [

+ {

+ "tool": "calculator",

+ "parameters": {"operation": "multiply", "x": 123, "y": 456},

+ },

+ {"tool": "weather_api", "parameters": {"city": "Paris", "country": "France"}},

+ ],

+ },

+ {"role": "tool", "tool_name": "calculator", "content": "56088"},

+ {

+ "role": "tool",

+ "tool_name": "weather_api",

+ "content": "{'condition': 'rain', 'temperature': 15}",

+ },

+]

+```

+

+## Cele mai bune practici

+

+### Ghiduri generale

+Când lucrați cu template-uri de chat, urmați aceste practici cheie:

+

+1. **Formatare consecventă**: Folosiți întotdeauna același format de template în toată aplicația

+2. **Definirea clară a rolurilor**: Specificați clar rolurile (sistem, utilizator, asistent, instrument) pentru fiecare mesaj

+3. **Gestionarea contextului**: Fiți atenți la limitele token-urilor când mențineți istoricul conversației

+4. **Gestionarea erorilor**: Includeți gestionarea adecvată a erorilor pentru apelurile de instrumente și intrările multimodale

+5. **Validare**: Validați structura mesajelor înainte de a le trimite la model

+

+

+Capcane comune de evitat:

+- Amestecarea diferitelor formate de template în aceeași aplicație

+- Depășirea limitelor de token-uri cu istoricuri lungi de conversație

+- Neescaparea corespunzătoare a caracterelor speciale în mesaje

+- Uitarea validării structurii mesajelor de intrare

+- Ignorarea cerințelor specifice de template ale modelului

+

+

+## Exercițiu practic

+

+Să exersăm implementarea template-urilor de chat cu un exemplu din lumea reală.

+

+

+Urmați acești pași pentru a converti setul de date `HuggingFaceTB/smoltalk` în formatul chatml:

+

+1. Încărcați setul de date:

+```python

+from datasets import load_dataset

+

+dataset = load_dataset("HuggingFaceTB/smoltalk")

+```

+

+2. Creați o funcție de procesare:

+```python

+def convert_to_chatml(example):

+ return {

+ "messages": [

+ {"role": "user", "content": example["input"]},

+ {"role": "assistant", "content": example["output"]},

+ ]

+ }

+```

+

+3. Aplicați template-ul de chat folosind tokenizer-ul modelului ales

+

+Amintiți-vă să validați că formatul de ieșire se potrivește cu cerințele modelului țintă!

+

+

+## Resurse adiționale

+

+- [Ghidul Hugging Face pentru template-uri de chat](https://huggingface.co/docs/transformers/main/en/chat_templating)

+- [Documentația Transformers](https://huggingface.co/docs/transformers)

+- [Depozitul de exemple pentru template-uri de chat](https://github.com/chujiezheng/chat_templates)

\ No newline at end of file

diff --git a/chapters/rum/chapter11/3.mdx b/chapters/rum/chapter11/3.mdx

new file mode 100644

index 000000000..1d9f924a2

--- /dev/null

+++ b/chapters/rum/chapter11/3.mdx

@@ -0,0 +1,384 @@

+

+

+# Fine-tuning supervizat

+

+Fine-tuningul supervizat (SFT) este un proces folosit în principal pentru a adapta modelele de limbaj pre-antrenate să urmeze instrucțiuni, să se angajeze în dialog și să folosească formate specifice de ieșire. În timp ce modelele pre-antrenate au capacități generale impresionante, SFT ajută la transformarea lor în modele asemănătoare asistentului care pot înțelege și răspunde mai bine la prompturile utilizatorilor. Acest lucru se realizează de obicei prin antrenare pe seturi de date cu conversații și instrucțiuni scrise de oameni.

+

+Această pagină oferă un ghid pas cu pas pentru fine-tuningul modelului [`deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B`](https://huggingface.co/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B) folosind [`SFTTrainer`](https://huggingface.co/docs/trl/en/sft_trainer). Urmând acești pași, puteți adapta modelul să îndeplinească anumite sarcini mai eficient.

+

+## Când să utilizați SFT

+

+Înainte de a se adânci în implementare, este important să înțelegem când SFT este alegerea potrivită pentru proiectul dumneavoastră. Ca primul pas, ar trebui să considerați dacă folosirea unui model existent ajustat pentru instrucțiuni cu prompturi bine elaborate ar fi suficientă pentru cazul dumneavoastră de utilizare. SFT implică resurse computaționale semnificative și efort de inginerie, așa că ar trebui urmărit doar când promptarea modelelor existente se dovedește insuficientă.

+

+

+Considerați SFT doar dacă:

+- Aveți nevoie de performanțe suplimentare dincolo de ceea ce poate realiza promptarea

+- Aveți un caz de utilizare specific în care costul folosirii unui model mare de uz general depășește costul fine-tuningului unui model mai mic

+- Aveți nevoie de formate de ieșire specializate sau cunoștințe specifice domeniului cu care modelele existente se confruntă

+

+

+Dacă determinați că SFT este necesar, decizia de a continua depinde de doi factori principali:

+

+### Controlul template-ului

+SFT permite control precis asupra structurii de ieșire a modelului. Acest lucru este deosebit de valoros când aveți nevoie ca modelul să:

+1. Genereze răspunsuri într-un format specific de template de chat

+2. Urmeze scheme stricte de ieșire

+3. Mențină stiluri consecvente în toate răspunsurile

+

+### Adaptarea la domeniu

+Când lucrați în domenii specializate, SFT ajută la alinierea modelului cu cerințele specifice domeniului prin:

+1. Predarea terminologiei și conceptelor domeniului

+2. Impunerea standardelor profesionale

+3. Gestionarea adecvată a întrebărilor tehnice

+4. Urmarea ghidurilor specifice industriei

+

+

+Înainte de a începe SFT, evaluați dacă cazul dumneavoastră de utilizare necesită:

+- Formatare precisă de ieșire

+- Cunoștințe specifice domeniului

+- Modele consecvente de răspuns

+- Aderarea la ghiduri specifice

+

+Această evaluare va ajuta să determinați dacă SFT este abordarea potrivită pentru nevoile dumneavoastră.

+

+

+## Pregătirea setului de date

+

+Procesul de fine-tuning supervizat necesită un set de date specific sarcinii structurat cu perechi intrare-ieșire. Fiecare pereche ar trebui să conțină:

+1. Un prompt de intrare

+2. Răspunsul așteptat al modelului

+3. Orice context sau metadate suplimentare

+

+Calitatea datelor de antrenare este crucială pentru succesul fine-tuningului. Să vedem cum să pregătim și să validăm setul de date:

+

+

+

+## Configurația antrenamentului

+

+Succesul fine-tuningului depinde în mare măsură de alegerea parametrilor de antrenare corecți. Să explorăm fiecare parametru important și cum să îi configurați eficient:

+

+Configurația SFTTrainer necesită considerarea mai multor parametri care controlează procesul de antrenare. Să explorăm fiecare parametru și scopul lor:

+

+1. **Parametrii duratei antrenamentului**:

+ - `num_train_epochs`: Controlează durata totală a antrenamentului

+ - `max_steps`: Alternativă la epoci, stabilește numărul maxim de pași de antrenare

+ - Mai multe epoci permit învățare mai bună dar riscă supraadaptarea

+

+2. **Parametrii dimensiunii batch-ului**:

+ - `per_device_train_batch_size`: Determină utilizarea memoriei și stabilitatea antrenamentului

+ - `gradient_accumulation_steps`: Permite dimensiuni efective mai mari ale batch-ului

+ - Batch-uri mai mari oferă gradienți mai stabili dar necesită mai multă memorie

+

+3. **Parametrii ratei de învățare**:

+ - `learning_rate`: Controlează dimensiunea actualizărilor greutăților

+ - `warmup_ratio`: Porțiunea de antrenament folosită pentru încălzirea ratei de învățare

+ - Prea mare poate cauza instabilitate, prea mică rezultă în învățare lentă

+

+4. **Parametrii de monitorizare**:

+ - `logging_steps`: Frecvența înregistrării metricilor

+ - `eval_steps`: Cât de des să evalueze pe datele de validare

+ - `save_steps`: Frecvența salvării punctelor de verificare ale modelului

+

+

+Începeți cu valori conservatoare și ajustați bazat pe monitorizare:

+- Începeți cu 1-3 epoci

+- Folosiți dimensiuni mai mici ale batch-ului inițial

+- Monitorizați metricile de validare atent

+- Ajustați rata de învățare dacă antrenamentul este instabil

+

+

+## Implementare cu TRL

+

+Acum că înțelegem componentele cheie, să implementăm antrenamentul cu validare și monitorizare adecvate. Vom folosi clasa `SFTTrainer` din biblioteca Transformers Reinforcement Learning (TRL), care este construită pe biblioteca `transformers`. Iată un exemplu complet folosind biblioteca TRL:

+

+```python

+from datasets import load_dataset

+from trl import SFTConfig, SFTTrainer

+import torch

+

+# Setați dispozitivul

+device = "cuda" if torch.cuda.is_available() else "cpu"

+

+# Încărcați setul de date

+dataset = load_dataset("HuggingFaceTB/smoltalk", "all")

+

+# Configurați modelul și tokenizer-ul

+model_name = "HuggingFaceTB/SmolLM2-135M"

+model = AutoModelForCausalLM.from_pretrained(pretrained_model_name_or_path=model_name).to(

+ device

+)

+tokenizer = AutoTokenizer.from_pretrained(pretrained_model_name_or_path=model_name)

+# Configurați template-ul de chat

+model, tokenizer = setup_chat_format(model=model, tokenizer=tokenizer)

+

+# Configurați trainer-ul

+training_args = SFTConfig(

+ output_dir="./sft_output",

+ max_steps=1000,

+ per_device_train_batch_size=4,

+ learning_rate=5e-5,

+ logging_steps=10,

+ save_steps=100,

+ eval_strategy="steps",

+ eval_steps=50,

+)

+

+# Inițializați trainer-ul

+trainer = SFTTrainer(

+ model=model,

+ args=training_args,

+ train_dataset=dataset["train"],

+ eval_dataset=dataset["test"],

+ processing_class=tokenizer,

+)

+

+# Începeți antrenamentul

+trainer.train()

+```

+

+

+Când folosiți un set de date cu un câmp "messages" (ca exemplul de mai sus), SFTTrainer aplică automat template-ul de chat al modelului, pe care îl recuperează de pe hub. Aceasta înseamnă că nu aveți nevoie de nicio configurație suplimentară pentru a gestiona conversațiile în stil chat - trainer-ul va formata mesajele conform formatului de template așteptat al modelului.

+

+

+## Împachetarea setului de date

+

+SFTTrainer suportă împachetarea exemplelor pentru a optimiza eficiența antrenamentului. Această funcționalitate permite ca mai multe exemple scurte să fie împachetate în aceeași secvență de intrare, maximizând utilizarea GPU în timpul antrenamentului. Pentru a activa împachetarea, pur și simplu setați `packing=True` în constructorul SFTConfig. Când folosiți seturi de date împachetate cu `max_steps`, fiți conștienți că s-ar putea să antrenați pentru mai multe epoci decât ați așteptat, în funcție de configurația de împachetare. Puteți personaliza modul în care exemplele sunt combinate folosind o funcție de formatare - deosebit de utilă când lucrați cu seturi de date care au mai multe câmpuri precum perechi întrebare-răspuns. Pentru seturile de date de evaluare, puteți dezactiva împachetarea setând `eval_packing=False` în SFTConfig. Iată un exemplu de bază de personalizare a configurației de împachetare:

+

+```python

+# Configurați împachetarea

+training_args = SFTConfig(packing=True)

+

+trainer = SFTTrainer(model=model, train_dataset=dataset, args=training_args)

+

+trainer.train()

+```

+

+Când împachetați setul de date cu mai multe câmpuri, puteți defini o funcție de formatare personalizată pentru a combina câmpurile într-o singură secvență de intrare. Această funcție ar trebui să ia o listă de exemple și să returneze un dicționar cu secvența de intrare împachetată. Iată un exemplu de funcție de formatare personalizată:

+

+```python

+def formatting_func(example):

+ text = f"### Question: {example['question']}\n ### Answer: {example['answer']}"

+ return text

+

+

+training_args = SFTConfig(packing=True)

+trainer = SFTTrainer(

+ "facebook/opt-350m",

+ train_dataset=dataset,

+ args=training_args,

+ formatting_func=formatting_func,

+)

+```

+

+## Monitorizarea progresului antrenamentului

+

+Monitorizarea eficientă este crucială pentru succesul fine-tuningului. Să explorăm ce să urmărim în timpul antrenamentului:

+

+### Înțelegerea modelelor de pierdere

+

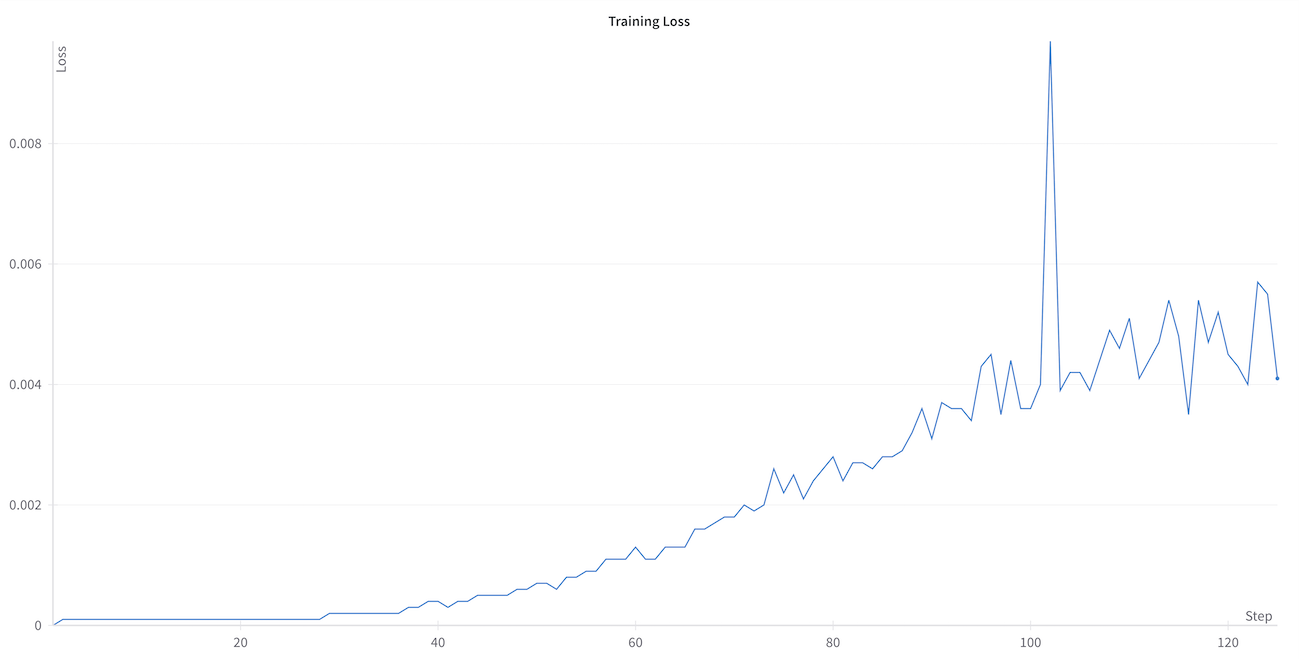

+Pierderea antrenamentului urmează de obicei trei faze distincte:

+1. Scădere abruptă inițială: Adaptare rapidă la noua distribuție de date

+2. Stabilizare graduală: Rata de învățare încetinește pe măsură ce modelul se ajustează fin

+3. Convergența: Valorile pierderilor se stabilizează, indicând finalizarea antrenamentului

+

+ +

+### Metrici de monitorizat

+

+Monitorizarea eficientă implică urmărirea metricilor cantitative și evaluarea metricilor calitative. Metricile disponibile sunt:

+

+- Pierderea antrenamentului

+- Pierderea validării

+- Progresia ratei de învățare

+- Normele gradientului

+

+

+Urmăriți aceste semne de avertizare în timpul antrenamentului:

+1. Pierderea validării crește în timp ce pierderea antrenamentului scade (supraadaptare)

+2. Nicio îmbunătățire semnificativă în valorile pierderilor (subadaptare)

+3. Valori extrem de mici ale pierderilor (posibilă memorizare)

+4. Formatare inconsistentă a ieșirii (probleme de învățare a template-ului)

+

+

+### Calea către convergență

+

+Pe măsură ce antrenamentul progresează, curba pierderii ar trebui să se stabilizeze treptat. Indicatorul cheie al antrenamentului sănătos este un decalaj mic între pierderea antrenamentului și cea de validare, sugerând că modelul învață modele generalizabile mai degrabă decât să memoreze exemple specifice. Valorile absolute ale pierderilor vor varia în funcție de sarcina și setul de date.

+

+### Monitorizarea progresului antrenamentului

+

+Graficul de mai sus arată o progresie tipică a antrenamentului. Observați cum atât pierderea antrenamentului, cât și cea de validare scad brusc la început, apoi se nivelează treptat. Acest model indică faptul că modelul învață eficient menținând în același timp capacitatea de generalizare.

+

+### Semne de avertizare de urmărit

+

+Mai multe modele în curbele pierderilor pot indica probleme potențiale. Mai jos ilustrăm semne comune de avertizare și soluții pe care le putem considera.

+

+

+

+### Metrici de monitorizat

+

+Monitorizarea eficientă implică urmărirea metricilor cantitative și evaluarea metricilor calitative. Metricile disponibile sunt:

+

+- Pierderea antrenamentului

+- Pierderea validării

+- Progresia ratei de învățare

+- Normele gradientului

+

+

+Urmăriți aceste semne de avertizare în timpul antrenamentului:

+1. Pierderea validării crește în timp ce pierderea antrenamentului scade (supraadaptare)

+2. Nicio îmbunătățire semnificativă în valorile pierderilor (subadaptare)

+3. Valori extrem de mici ale pierderilor (posibilă memorizare)

+4. Formatare inconsistentă a ieșirii (probleme de învățare a template-ului)

+

+

+### Calea către convergență

+

+Pe măsură ce antrenamentul progresează, curba pierderii ar trebui să se stabilizeze treptat. Indicatorul cheie al antrenamentului sănătos este un decalaj mic între pierderea antrenamentului și cea de validare, sugerând că modelul învață modele generalizabile mai degrabă decât să memoreze exemple specifice. Valorile absolute ale pierderilor vor varia în funcție de sarcina și setul de date.

+

+### Monitorizarea progresului antrenamentului

+

+Graficul de mai sus arată o progresie tipică a antrenamentului. Observați cum atât pierderea antrenamentului, cât și cea de validare scad brusc la început, apoi se nivelează treptat. Acest model indică faptul că modelul învață eficient menținând în același timp capacitatea de generalizare.

+

+### Semne de avertizare de urmărit

+

+Mai multe modele în curbele pierderilor pot indica probleme potențiale. Mai jos ilustrăm semne comune de avertizare și soluții pe care le putem considera.

+

+ +

+Dacă pierderea validării scade cu o rată semnificativ mai lentă decât pierderea antrenamentului, modelul probabil se supraadaptează la datele de antrenare. Considerați:

+- Reducerea pașilor de antrenare

+- Creșterea dimensiunii setului de date

+- Validarea calității și diversității setului de date

+

+

+

+Dacă pierderea validării scade cu o rată semnificativ mai lentă decât pierderea antrenamentului, modelul probabil se supraadaptează la datele de antrenare. Considerați:

+- Reducerea pașilor de antrenare

+- Creșterea dimensiunii setului de date

+- Validarea calității și diversității setului de date

+

+ +

+Dacă pierderea nu arată îmbunătățiri semnificative, modelul ar putea să:

+- Învețe prea încet (încercați să creșteți rata de învățare)

+- Se confrunte cu sarcina (verificați calitatea datelor și complexitatea sarcinii)

+- Atingă limitările arhitecturii (considerați un model diferit)

+

+

+

+Dacă pierderea nu arată îmbunătățiri semnificative, modelul ar putea să:

+- Învețe prea încet (încercați să creșteți rata de învățare)

+- Se confrunte cu sarcina (verificați calitatea datelor și complexitatea sarcinii)

+- Atingă limitările arhitecturii (considerați un model diferit)

+

+ +

+Valori extrem de mici ale pierderilor ar putea sugera memorizare mai degrabă decât învățare. Acest lucru este deosebit de îngrijorător dacă:

+- Modelul performează slab pe exemple noi, similare

+- Ieșirile lipsesc de diversitate

+- Răspunsurile sunt prea similare cu exemplele de antrenare

+

+

+Monitorizați atât valorile pierderilor, cât și ieșirile efective ale modelului în timpul antrenamentului. Uneori pierderea poate arăta bine în timp ce modelul dezvoltă comportamente nedorite. Evaluarea calitativă regulată a răspunsurilor modelului ajută la detectarea problemelor pe care metricile singure le-ar putea rata.

+

+

+Ar trebui să observăm că interpretarea valorilor pierderilor pe care o descriem aici este destinată cazului cel mai comun, și de fapt, valorile pierderilor se pot comporta în moduri diferite în funcție de model, setul de date, parametrii de antrenare, etc. Dacă sunteți interesați să explorați mai multe despre modelele descrise, ar trebui să consultați acest articol de blog de la oamenii de la [Fast AI](https://www.fast.ai/posts/2023-09-04-learning-jumps/).

+

+## Evaluarea după SFT

+

+În secțiunea [11.4](/en/chapter11/4) vom învăța cum să evaluăm modelul folosind seturi de date de referință. Pentru moment, ne vom concentra pe evaluarea calitativă a modelului.

+

+După finalizarea SFT, considerați aceste acțiuni de urmărire:

+

+1. Evaluați modelul temeinic pe datele de test păstrate deoparte

+2. Validați aderarea la template pe diverse intrări

+3. Testați reținerea cunoștințelor specifice domeniului

+4. Monitorizați metricile de performanță din lumea reală

+

+

+Documentați procesul de antrenare, inclusiv:

+- Caracteristicile setului de date

+- Parametrii antrenamentului

+- Metricile de performanță

+- Limitările cunoscute

+Această documentație va fi valoroasă pentru iterațiile viitoare ale modelului.

+

+

+## Chestionar

+

+### 1. Ce parametri controlează durata antrenamentului în SFT?

+

+

+

+### 2. Ce model în curbele pierderilor indică supraadaptarea potențială?

+

+

+

+### 3. Pentru ce este folosit gradient_accumulation_steps?

+

+

+

+### 4. Ce ar trebui să monitorizați în timpul antrenamentului SFT?

+

+

+

+### 5. Ce indică convergența sănătoasă în timpul antrenamentului?

+

+

+

+## 💐 Bună treabă!

+

+Ați învățat cum să faceți fine-tuning la modele folosind SFT! Pentru a continua învățarea:

+1. Încercați notebook-ul cu parametri diferiți

+2. Experimentați cu alte seturi de date

+3. Contribuiți cu îmbunătățiri la materialul cursului

+

+## Resurse adiționale

+

+- [Documentația TRL](https://huggingface.co/docs/trl)

+- [Depozitul de exemple SFT](https://github.com/huggingface/trl/blob/main/trl/scripts/sft.py)

+- [Cele mai bune practici pentru fine-tuning](https://huggingface.co/docs/transformers/training)

\ No newline at end of file

diff --git a/chapters/rum/chapter11/4.mdx b/chapters/rum/chapter11/4.mdx

new file mode 100644

index 000000000..f243b94e3

--- /dev/null

+++ b/chapters/rum/chapter11/4.mdx

@@ -0,0 +1,171 @@

+

+

+# LoRA (Adaptarea de rang scăzut)

+

+Fine-tuningul modelelor mari de limbaj este un proces intensiv în resurse. LoRA este o tehnică care ne permite să facem fine-tuning la modele mari de limbaj cu un număr mic de parametri. Funcționează prin adăugarea și optimizarea unor matrice mai mici la greutățile atenției, reducând de obicei parametrii antrenabili cu aproximativ 90%.

+

+## Înțelegerea LoRA

+

+LoRA (Adaptarea de rang scăzut) este o tehnică de fine-tuning eficientă din punct de vedere al parametrilor care îngheață greutățile modelului pre-antrenat și injectează matrice de descompunere de rang antrenabile în straturile modelului. În loc să antreneze toți parametrii modelului în timpul fine-tuningului, LoRA descompune actualizările greutăților în matrice mai mici prin descompunere de rang scăzut, reducând semnificativ numărul de parametri antrenabili menținând în același timp performanța modelului. De exemplu, când este aplicat la GPT-3 175B, LoRA a redus parametrii antrenabili de 10.000 de ori și cerințele de memorie GPU de 3 ori comparativ cu fine-tuningul complet. Puteți citi mai multe despre LoRA în [lucrarea LoRA](https://arxiv.org/pdf/2106.09685).

+

+LoRA funcționează prin adăugarea de perechi de matrice de descompunere de rang la straturile transformer, concentrându-se de obicei pe greutățile atenției. În timpul inferenței, aceste greutăți ale adaptorului pot fi îmbinate cu modelul de bază, rezultând în nicio latență suplimentară. LoRA este deosebit de util pentru adaptarea modelelor mari de limbaj la sarcini sau domenii specifice menținând în același timp cerințele de resurse gestionabile.

+

+## Avantajele cheie ale LoRA

+

+1. **Eficiența memoriei**:

+ - Doar parametrii adaptorului sunt stocați în memoria GPU

+ - Greutățile modelului de bază rămân înghețate și pot fi încărcate la precizie mai mică

+ - Permite fine-tuningul modelelor mari pe GPU-uri de consum

+

+2. **Caracteristici de antrenare**:

+ - Integrare nativă PEFT/LoRA cu configurare minimă

+ - Suport pentru QLoRA (LoRA cuantificat) pentru eficiență de memorie și mai bună

+

+3. **Gestionarea adaptorului**:

+ - Salvarea greutăților adaptorului în timpul punctelor de verificare

+ - Funcționalități pentru îmbinarea adaptorilor înapoi în modelul de bază

+

+## Încărcarea adaptorilor LoRA cu PEFT

+

+[PEFT](https://github.com/huggingface/peft) este o bibliotecă care oferă o interfață unificată pentru încărcarea și gestionarea metodelor PEFT, inclusiv LoRA. Vă permite să încărcați și să comutați cu ușurință între diferite metode PEFT, făcând mai ușor să experimentați cu diferite tehnici de fine-tuning.

+

+Adaptorii pot fi încărcați pe un model pre-antrenat cu `load_adapter()`, care este util pentru a încerca adaptori diferiți ale căror greutăți nu sunt îmbinate. Setați greutățile adaptorului activ cu funcția `set_adapter()`. Pentru a reveni la modelul de bază, ați putea folosi unload() pentru a descărca toate modulele LoRA. Acest lucru face ușor să comutați între greutăți specifice sarcinilor diferite.

+

+```python

+from peft import PeftModel, PeftConfig

+

+config = PeftConfig.from_pretrained("ybelkada/opt-350m-lora")

+model = AutoModelForCausalLM.from_pretrained(config.base_model_name_or_path)

+lora_model = PeftModel.from_pretrained(model, "ybelkada/opt-350m-lora")

+```

+

+

+

+## Fine-tuning LLM folosind `trl` și `SFTTrainer` cu LoRA

+

+[SFTTrainer](https://huggingface.co/docs/trl/sft_trainer) din `trl` oferă integrare cu adaptorii LoRA prin biblioteca [PEFT](https://huggingface.co/docs/peft/en/index). Aceasta înseamnă că putem face fine-tuning la un model în același mod ca și cu SFT, dar folosim LoRA pentru a reduce numărul de parametri pe care trebuie să îi antrenăm.

+

+Vom folosi clasa `LoRAConfig` din PEFT în exemplul nostru. Configurarea necesită doar câțiva pași de configurare:

+

+1. Definiți configurația LoRA (rang, alfa, dropout)

+2. Creați SFTTrainer cu configurația PEFT

+3. Antrenați și salvați greutățile adaptorului

+

+## Configurația LoRA

+

+Să parcurgem configurația LoRA și parametrii cheie.

+

+| Parametru | Descriere |

+|-----------|-----------|

+| `r` (rang) | Dimensiunea matricelor de rang scăzut folosite pentru actualizările greutăților. De obicei între 4-32. Valori mai mici oferă mai multă compresie dar potențial mai puțină expresivitate. |

+| `lora_alpha` | Factor de scalare pentru straturile LoRA, de obicei setat la 2x valoarea rangului. Valori mai mari rezultă în efecte de adaptare mai puternice. |

+| `lora_dropout` | Probabilitatea dropout pentru straturile LoRA, de obicei 0.05-0.1. Valori mai mari ajută la prevenirea supraadaptării în timpul antrenamentului. |

+| `bias` | Controlează antrenarea termenilor de bias. Opțiunile sunt "none", "all" sau "lora_only". "none" este cel mai comun pentru eficiența memoriei. |

+| `target_modules` | Specifică la care module ale modelului să aplice LoRA. Poate fi "all-linear" sau module specifice precum "q_proj,v_proj". Mai multe module permit o adaptabilitate mai mare dar cresc utilizarea memoriei. |

+

+

+Când implementați metode PEFT, începeți cu valori mici ale rangului (4-8) pentru LoRA și monitorizați pierderea antrenamentului. Folosiți seturi de validare pentru a preveni supraadaptarea și comparați rezultatele cu liniile de bază de fine-tuning complet când este posibil. Eficacitatea diferitelor metode poate varia în funcție de sarcină, așa că experimentarea este cheia.

+

+

+## Folosirea TRL cu PEFT

+

+Metodele PEFT pot fi combinate cu TRL pentru fine-tuning pentru a reduce cerințele de memorie. Putem trece `LoraConfig` la model când îl încărcăm.

+

+```python

+from peft import LoraConfig

+

+# TODO: Configurați parametrii LoRA

+# r: dimensiunea rangului pentru matricele de actualizare LoRA (mai mică = mai multă compresie)

+rank_dimension = 6

+# lora_alpha: factor de scalare pentru straturile LoRA (mai mare = adaptare mai puternică)

+lora_alpha = 8

+# lora_dropout: probabilitatea dropout pentru straturile LoRA (ajută la prevenirea supraadaptării)

+lora_dropout = 0.05

+

+peft_config = LoraConfig(

+ r=rank_dimension, # Dimensiunea rangului - de obicei între 4-32

+ lora_alpha=lora_alpha, # Factor de scalare LoRA - de obicei 2x rangul

+ lora_dropout=lora_dropout, # Probabilitatea dropout pentru straturile LoRA

+ bias="none", # Tipul bias pentru LoRA. bias-urile corespunzătoare vor fi actualizate în timpul antrenamentului.

+ target_modules="all-linear", # La care module să aplice LoRA

+ task_type="CAUSAL_LM", # Tipul sarcinii pentru arhitectura modelului

+)

+```

+

+Mai sus, am folosit `device_map="auto"` pentru a atribui automat modelul la dispozitivul corect. De asemenea, puteți atribui manual modelul la un dispozitiv specific folosind `device_map={"": device_index}`.

+

+Vom avea nevoie, de asemenea, să definim `SFTTrainer` cu configurația LoRA.

+

+```python

+# Creați SFTTrainer cu configurația LoRA

+trainer = SFTTrainer(

+ model=model,

+ args=args,

+ train_dataset=dataset["train"],

+ peft_config=peft_config, # Configurația LoRA

+ max_seq_length=max_seq_length, # Lungimea maximă a secvenței

+ processing_class=tokenizer,

+)

+```

+

+

+

+✏️ **Încercați!** Construiți pe modelul dumneavoastră ajustat fin din secțiunea anterioară, dar faceți fine-tuning cu LoRA. Folosiți setul de date `HuggingFaceTB/smoltalk` pentru a face fine-tuning la un model `deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B`, folosind configurația LoRA pe care am definit-o mai sus.

+

+

+

+## Îmbinarea adaptorilor LoRA

+

+După antrenarea cu LoRA, s-ar putea să doriți să îmbinați greutățile adaptorului înapoi în modelul de bază pentru implementare mai ușoară. Aceasta creează un singur model cu greutățile combinate, eliminând necesitatea de a încărca adaptorii separat în timpul inferenței.

+

+Procesul de îmbinare necesită atenție la gestionarea memoriei și precizie. Deoarece va trebui să încărcați atât modelul de bază, cât și greutățile adaptorului simultan, asigurați-vă că există memorie GPU/CPU suficientă disponibilă. Folosirea `device_map="auto"` în `transformers` va găsi dispozitivul corect pentru model bazat pe hardware-ul dumneavoastră.

+

+Mențineți precizia consistentă (de ex. float16) pe tot parcursul procesului, potrivind precizia folosită în timpul antrenamentului și salvând modelul îmbinat în același format pentru implementare.

+

+## Implementarea îmbinării

+

+După antrenarea unui adaptor LoRA, puteți îmbina greutățile adaptorului înapoi în modelul de bază. Iată cum să faceți acest lucru:

+

+```python

+import torch

+from transformers import AutoModelForCausalLM

+from peft import PeftModel

+

+# 1. Încărcați modelul de bază

+base_model = AutoModelForCausalLM.from_pretrained(

+ "base_model_name", torch_dtype=torch.float16, device_map="auto"

+)

+

+# 2. Încărcați modelul PEFT cu adaptorul

+peft_model = PeftModel.from_pretrained(

+ base_model, "path/to/adapter", torch_dtype=torch.float16

+)

+

+# 3. Îmbinați greutățile adaptorului cu modelul de bază

+merged_model = peft_model.merge_and_unload()

+```

+

+Dacă întâmpinați discrepanțe de dimensiune în modelul salvat, asigurați-vă că salvați și tokenizer-ul:

+

+```python

+# Salvați atât modelul, cât și tokenizer-ul

+tokenizer = AutoTokenizer.from_pretrained("base_model_name")

+merged_model.save_pretrained("path/to/save/merged_model")

+tokenizer.save_pretrained("path/to/save/merged_model")

+```

+

+

+

+✏️ **Încercați!** Îmbinați greutățile adaptorului înapoi în modelul de bază. Folosiți setul de date `HuggingFaceTB/smoltalk` pentru a face fine-tuning la un model `deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B`, folosind configurația LoRA pe care am definit-o mai sus.

+

+

+

+# Resurse

+

+- [LoRA: Adaptarea de rang scăzut a modelelor mari de limbaj](https://arxiv.org/pdf/2106.09685)

+- [Documentația PEFT](https://huggingface.co/docs/peft)

+- [Articolul de blog Hugging Face despre PEFT](https://huggingface.co/blog/peft)

\ No newline at end of file

diff --git a/chapters/rum/chapter11/5.mdx b/chapters/rum/chapter11/5.mdx

new file mode 100644

index 000000000..61ca3c867

--- /dev/null

+++ b/chapters/rum/chapter11/5.mdx

@@ -0,0 +1,254 @@

+# Evaluarea

+

+Cu un model ajustat fin prin SFT sau LoRA SFT, ar trebui să îl evaluăm pe criterii de referință standard. Ca ingineri de machine learning, ar trebui să mențineți o suită de evaluări relevante pentru domeniul dumneavoastră țintă de interes. În această pagină, vom privi la unele dintre criteriile de referință cele mai comune și cum să le folosiți pentru a evalua modelul dumneavoastră. De asemenea, vom vedea cum să creați criterii de referință personalizate pentru cazul specific de utilizare.

+

+## Criterii de referință automate

+

+Criteriile de referință automate servesc ca instrumente standardizate pentru evaluarea modelelor de limbaj pe diferite sarcini și capacități. În timp ce acestea oferă un punct de plecare util pentru înțelegerea performanței modelului, este important să recunoaștem că reprezintă doar o piesă dintr-o strategie de evaluare cuprinzătoare.

+

+## Înțelegerea criteriilor de referință automate

+

+Criteriile de referință automate constau de obicei din seturi de date curate cu sarcini și metrici de evaluare predefinite. Aceste criterii de referință au ca scop să evalueze diverse aspecte ale capacității modelului, de la înțelegerea de bază a limbajului la raționament complex. Avantajul cheie al folosirii criteriilor de referință automate este standardizarea lor - permit compararea consistentă între modele diferite și oferă rezultate reproductibile.

+

+Cu toate acestea, este crucial să înțelegem că performanța la criterii de referință nu se traduce întotdeauna direct în eficacitate din lumea reală. Un model care excelează la criterii de referință academice poate totuși să se confrunte cu aplicații de domeniu specifice sau cazuri de utilizare practice.

+

+## Criterii de referință pentru cunoștințe generale

+

+[MMLU](https://huggingface.co/datasets/cais/mmlu) (Massive Multitask Language Understanding) testează cunoștințele pe 57 de subiecte, de la știință la științe umane. Deși cuprinzător, poate să nu reflecte profunzimea expertizei necesare pentru domenii specifice. TruthfulQA evaluează tendința unui model de a reproduce concepții greșite comune, deși nu poate captura toate formele de dezinformare.

+

+## Criterii de referință pentru raționament

+

+[BBH](https://huggingface.co/datasets/lukaemon/bbh) (Big Bench Hard) și [GSM8K](https://huggingface.co/datasets/openai/gsm8k) se concentrează pe sarcini de raționament complex. BBH testează gândirea logică și planificarea, în timp ce GSM8K vizează specific rezolvarea problemelor matematice. Aceste criterii de referință ajută la evaluarea capacităților analitice dar pot să nu captureze raționamentul nuanțat necesar în scenarii din lumea reală.

+

+## Înțelegerea limbajului

+

+[HELM](https://github.com/stanford-crfm/helm) oferă un cadru de evaluare holistic. Criterii de referință precum HELM oferă perspective asupra capacităților de procesare a limbajului pe aspecte precum bunul simț, cunoștințele despre lume și raționamentul. Dar pot să nu reprezinte complet complexitatea conversației naturale sau terminologia specifică domeniului.

+

+## Criterii de referință specifice domeniului

+

+Să ne uităm la câteva criterii de referință care se concentrează pe domenii specifice precum matematica, codarea și chatul.

+

+[Criteriul de referință MATH](https://huggingface.co/papers/2103.03874) este un alt instrument important de evaluare pentru raționamentul matematic. Constă din 12.500 de probleme din competiții de matematică, acoperind algebra, geometria, teoria numerelor, numărarea, probabilitatea și altele. Ceea ce face MATH deosebit de provocator este că necesită raționament în mai mulți pași, înțelegerea notației matematice formale și capacitatea de a genera soluții pas cu pas. Spre deosebire de sarcinile aritmetice mai simple, problemele MATH necesită adesea strategii sofisticate de rezolvare a problemelor și aplicații de concepte matematice.

+

+[Criteriul de referință HumanEval](https://github.com/openai/human-eval) este un set de date de evaluare axat pe codare format din 164 de probleme de programare. Criteriul de referință testează capacitatea unui model de a genera cod Python funcțional corect care rezolvă sarcinile de programare date. Ceea ce face HumanEval deosebit de valoros este că evaluează atât capacitățile de generare de cod, cât și corectitudinea funcțională prin executarea efectivă a cazurilor de test, mai degrabă decât doar similaritatea superficială cu soluțiile de referință. Problemele variază de la manipularea de bază a șirurilor la algoritmi și structuri de date mai complexe.

+

+[Alpaca Eval](https://tatsu-lab.github.io/alpaca_eval/) este un cadru de evaluare automatizat conceput pentru a evalua calitatea modelelor de limbaj care urmează instrucțiuni. Folosește GPT-4 ca judecător pentru a evalua ieșirile modelului pe diverse dimensiuni, inclusiv utilitatea, onestitatea și inofensivitatea. Cadrul include un set de date cu 805 de prompturi atent curate și poate evalua răspunsurile față de modele multiple de referință precum Claude, GPT-4 și altele. Ceea ce face Alpaca Eval deosebit de util este capacitatea sa de a oferi evaluări consistente, scalabile fără a necesita adnotatori umani, în timp ce încă capturează aspecte nuanțate ale performanței modelului pe care metricile tradiționale le-ar putea rata.

+

+## Abordări alternative de evaluare

+

+Multe organizații au dezvoltat metode alternative de evaluare pentru a aborda limitările criteriilor de referință standard:

+

+### LLM-ca-judecător

+

+Folosirea unui model de limbaj pentru a evalua ieșirile altuia a devenit din ce în ce mai populară. Această abordare poate oferi feedback mai nuanțat decât metricile tradiționale, deși vine cu propriile sale prejudecăți și limitări.

+

+### Arene de evaluare

+

+Arenele de evaluare precum [Chatbot Arena](https://lmarena.ai/) oferă o abordare unică pentru evaluarea LLM prin feedback crowdsourced. În aceste platforme, utilizatorii se angajează în "bătălii" anonime între două LLM-uri, punând întrebări și votând care model oferă răspunsuri mai bune. Această abordare capturează modelele de utilizare și preferințele din lumea reală prin întrebări diverse, provocatoare, cu studii care arată acord puternic între voturile crowdsourced și evaluările experților. Deși puternice, aceste platforme au limitări, inclusiv prejudecăți potențiale ale bazei de utilizatori, distribuții distorsionate ale prompturilor și o concentrare principală pe utilitate mai degrabă decât pe considerațiile de siguranță.

+

+### Suite de criterii de referință personalizate

+

+Organizațiile dezvoltă adesea suite interne de criterii de referință adaptate nevoilor și cazurilor lor specifice de utilizare. Acestea ar putea include teste de cunoștințe specifice domeniului sau scenarii de evaluare care reflectă condițiile reale de implementare.

+

+## Evaluare personalizată

+

+În timp ce criteriile de referință standard oferă o linie de bază utilă, nu ar trebui să fie singura metodă de evaluare. Iată cum să dezvoltați o abordare mai cuprinzătoare:

+

+1. Începeți cu criterii de referință standard relevante pentru a stabili o linie de bază și a permite comparația cu alte modele.

+

+2. Identificați cerințele și provocările specifice ale cazului dumneavoastră de utilizare. Ce sarcini va îndeplini efectiv modelul? Ce tipuri de erori ar fi cele mai problematice?

+

+3. Dezvoltați seturi de date de evaluare personalizate care reflectă cazul real de utilizare. Aceasta ar putea include:

+ - Întrebări reale ale utilizatorilor din domeniul dumneavoastră

+ - Cazuri comune de margine pe care le-ați întâlnit

+ - Exemple de scenarii deosebit de provocatoare

+

+4. Considerați implementarea unei strategii de evaluare pe mai multe niveluri:

+ - Metrici automate pentru feedback rapid

+ - Evaluare umană pentru înțelegere nuanțată

+ - Revizuire de experți de domeniu pentru aplicații specializate

+ - Testare A/B în medii controlate

+

+## Implementarea evaluărilor personalizate

+

+În această secțiune, vom implementa evaluarea pentru modelul nostru ajustat fin. Putem folosi [`lighteval`](https://github.com/huggingface/lighteval) pentru a evalua modelul nostru ajustat fin pe criterii de referință standard, care conține o gamă largă de sarcini încorporate în bibliotecă. Trebuie doar să definim sarcinile pe care dorim să le evaluăm și parametrii pentru evaluare.

+

+Sarcinile LightEval sunt definite folosind un format specific:

+

+```

+{suite}|{task}|{num_few_shot}|{auto_reduce}

+```

+

+| Parametru | Descriere |

+|-----------|-----------|

+| `suite` | Suita de criterii de referință (de ex., 'mmlu', 'truthfulqa') |

+| `task` | Sarcina specifică din suită (de ex., 'abstract_algebra') |

+| `num_few_shot` | Numărul de exemple de inclus în prompt (0 pentru zero-shot) |

+| `auto_reduce` | Dacă să reducă automat exemplele few-shot dacă promptul este prea lung (0 sau 1) |

+

+Exemplu: `"mmlu|abstract_algebra|0|0"` evaluează pe sarcina de algebră abstractă MMLU cu inferență zero-shot.

+

+## Exemplu de pipeline de evaluare

+

+Să configurăm un pipeline de evaluare pentru modelul nostru ajustat fin. Vom evalua modelul pe un set de sub-sarcini care se raportează la domeniul medicinei.

+

+Iată un exemplu complet de evaluare pe criterii de referință automate relevante pentru un domeniu specific folosind Lighteval cu backend-ul VLLM:

+

+```bash

+lighteval accelerate \

+ "pretrained=your-model-name" \

+ "mmlu|anatomy|0|0" \

+ "mmlu|high_school_biology|0|0" \

+ "mmlu|high_school_chemistry|0|0" \

+ "mmlu|professional_medicine|0|0" \

+ --max_samples 40 \

+ --batch_size 1 \

+ --output_path "./results" \

+ --save_generations true

+```

+

+Rezultatele sunt afișate în format tabular arătând:

+

+```

+| Task |Version|Metric|Value | |Stderr|

+|----------------------------------------|------:|------|-----:|---|-----:|

+|all | |acc |0.3333|± |0.1169|

+|leaderboard:mmlu:_average:5 | |acc |0.3400|± |0.1121|

+|leaderboard:mmlu:anatomy:5 | 0|acc |0.4500|± |0.1141|

+|leaderboard:mmlu:high_school_biology:5 | 0|acc |0.1500|± |0.0819|

+```

+

+Lighteval include, de asemenea, un API Python pentru sarcini de evaluare mai detaliate, care este util pentru manipularea rezultatelor într-un mod mai flexibil. Consultați [documentația Lighteval](https://huggingface.co/docs/lighteval/using-the-python-api) pentru mai multe informații.

+

+

+

+✏️ **Încercați!** Evaluați modelul dumneavoastră ajustat fin pe o sarcină specifică în lighteval.

+

+

+

+# Chestionar de sfârșit de capitol[[end-of-chapter-quiz]]

+

+

+

+### 1. Care sunt principalele avantaje ale folosirii criteriilor de referință automate pentru evaluarea modelului?

+

+

+

+### 2. Care criteriu de referință testează specific cunoștințele pe 57 de subiecte diferite?

+

+

+

+### 3. Ce este LLM-ca-judecător?

+

+

+

+### 4. Ce ar trebui inclus într-o strategie de evaluare cuprinzătoare?

+

+

+

+### 5. Care este o limitare a criteriilor de referință automate?

+

+

+

+### 6. Care este scopul creării seturilor de date de evaluare personalizate?

+

+

\ No newline at end of file

diff --git a/chapters/rum/chapter11/6.mdx b/chapters/rum/chapter11/6.mdx

new file mode 100644

index 000000000..89356375e

--- /dev/null

+++ b/chapters/rum/chapter11/6.mdx

@@ -0,0 +1,13 @@

+# Concluzie

+

+În acest capitol, am explorat componentele esențiale ale fine-tuningului modelelor de limbaj:

+

+1. **Template-urile de chat** oferă structură interacțiunilor cu modelul, asigurând răspunsuri consecvente și adecvate prin formatare standardizată.

+

+2. **Fine-tuningul supervizat (SFT)** permite adaptarea modelelor pre-antrenate la sarcini specifice menținând în același timp cunoștințele lor fundamentale.

+

+3. **LoRA** oferă o abordare eficientă pentru fine-tuning prin reducerea parametrilor antrenabili păstrând în același timp performanța modelului.

+

+4. **Evaluarea** ajută la măsurarea și validarea eficacității fine-tuningului prin diverse metrici și criterii de referință.

+

+Aceste tehnici, când sunt combinate, permit crearea de modele specializate de limbaj care pot excela în sarcini specifice rămânând în același timp eficiente din punct de vedere computațional. Indiferent dacă construiți un bot de servicii pentru clienți sau un asistent specific domeniului, înțelegerea acestor concepte este crucială pentru adaptarea cu succes a modelului.

\ No newline at end of file

diff --git a/chapters/rum/chapter11/7.mdx b/chapters/rum/chapter11/7.mdx

new file mode 100644

index 000000000..2ef2c530e

--- /dev/null

+++ b/chapters/rum/chapter11/7.mdx

@@ -0,0 +1,31 @@

+# E timpul examenului!

+

+E timpul să vă puneți cunoștințele la încercare! Am pregătit un scurt chestionar pentru a vă testa înțelegerea conceptelor abordate în acest capitol.

+

+Pentru a face chestionarul, va trebui să urmați acești pași:

+

+1. Conectați-vă la contul dumneavoastră Hugging Face.

+2. Răspundeți la întrebările din chestionar.

+3. Trimiteți răspunsurile dumneavoastră.

+

+## Chestionar cu alegere multiplă

+

+În acest chestionar, vi se va cere să selectați răspunsul corect dintr-o listă de opțiuni. Vă vom testa pe elementele fundamentale ale fine-tuningului supervizat.

+

+

+

+## Chestionar de cod

+

+În acest chestionar, vi se va cere să scrieți cod pentru a completa o sarcină. Vă vom testa pe codul pe care l-ați studiat în curs din biblioteci precum `datasets`, `transformers`, `peft` și `TRL`.

+

+

\ No newline at end of file

diff --git a/chapters/rum/chapter12/1.mdx b/chapters/rum/chapter12/1.mdx

new file mode 100644

index 000000000..4dbae17fa

--- /dev/null

+++ b/chapters/rum/chapter12/1.mdx

@@ -0,0 +1,93 @@

+# Open R1 pentru Studenți

+

+Bun venit într-o călătorie captivantă în lumea AI-ului open-source cu învățarea prin întărire! Acest capitol este conceput pentru a ajuta studenții să înțeleagă învățarea prin întărire și rolul acesteia în LLM-uri.

+

+De asemenea, vom explora [Open R1](https://github.com/huggingface/open-r1), un proiect comunitar revoluționar care face AI-ul avansat accesibil pentru toată lumea. În mod specific, acest curs este pentru a ajuta studenții și cursanții să folosească și să contribuie la [Open R1](https://github.com/huggingface/open-r1).

+

+## Ce Vei Învăța

+

+În acest capitol, vom descompune concepte complexe în părți ușor de înțeles și îți vom arăta cum poți fi parte din acest proiect captivant de a face LLM-urile să raționeze asupra problemelor complexe.

+

+LLM-urile au demonstrat performanțe excelente pe multe sarcini generative. Cu toate acestea, până recent, au avut dificultăți cu problemele complexe care necesită raționament. De exemplu, le este greu să se descurce cu puzzle-uri sau probleme de matematică care necesită mai mulți pași de raționament.

+

+Open R1 este un proiect care își propune să facă LLM-urile să raționeze asupra problemelor complexe. Face acest lucru folosind învățarea prin întărire pentru a încuraja LLM-urile să 'gândească' și să raționeze.

+

+În termeni simpli, modelul este antrenat să genereze gânduri precum și rezultate, și să structureze aceste gânduri și rezultate astfel încât să poată fi gestionate separat de către utilizator.

+

+Să aruncăm o privire la un exemplu. Dacă ne-am dat nouă înșine sarcina de a rezolva următoarea problemă, am putea gândi astfel:

+

+```sh

+Problemă: "Am 3 mere și 2 portocale. Câte bucăți de fructe am în total?"

+

+Gând: "Trebuie să adun numărul de mere și portocale pentru a obține numărul total de bucăți de fructe."

+

+Răspuns: "5"

+```

+

+Putem apoi să structurăm acest gând și răspuns astfel încât să poată fi gestionate separat de către utilizator. Pentru sarcinile de raționament, LLM-urile pot fi antrenate să genereze gânduri și răspunsuri în următorul format:

+

+```sh

+Trebuie să adun numărul de mere și portocale pentru a obține numărul total de bucăți de fructe.

+5

+```

+

+Ca utilizator, putem apoi să extragem gândul și răspunsul din rezultatul modelului și să le folosim pentru a rezolva problema.

+

+## De Ce Este Important Pentru Studenți

+

+Ca student, înțelegerea Open R1 și a rolului învățării prin întărire în LLM-uri este valoroasă pentru că:

+- Îți arată cum se dezvoltă AI-ul de ultimă generație

+- Îți oferă oportunități practice de a învăța și contribui

+- Te ajută să înțelegi înspre unde se îndreaptă tehnologia AI

+- Îți deschide uși către viitoare oportunități de carieră în AI

+

+## Prezentarea Capitolului

+

+Acest capitol este împărțit în patru secțiuni, fiecare concentrându-se pe un aspect diferit al Open R1:

+

+### 1️⃣ Introducere în Învățarea prin Întărire și rolul acesteia în LLM-uri

+Vom explora elementele de bază ale Învățării prin Întărire (RL) și rolul acesteia în antrenarea LLM-urilor.

+- Ce este RL?

+- Cum este folosit RL în LLM-uri?

+- Ce este DeepSeek R1?

+- Care sunt inovațiile cheie ale DeepSeek R1?

+

+### 2️⃣ Înțelegerea Lucrării DeepSeek R1

+Vom descompune lucrarea de cercetare care a inspirat [Open R1](https://huggingface.co/open-r1):

+- Inovații și descoperiri cheie

+- Procesul de antrenare și arhitectura

+- Rezultate și semnificația lor

+

+### 3️⃣ Implementarea GRPO în TRL

+Vom deveni practici cu exemple de cod:

+- Cum să folosești biblioteca Transformer Reinforcement Learning (TRL)

+- Configurarea antrenamentului GRPO

+

+### 4️⃣ Caz de utilizare practic pentru alinierea unui model

+Vom privi un caz de utilizare practic pentru alinierea unui model folosind Open R1.

+- Cum să antrenezi un model folosind GRPO în TRL

+- Să-ți partajezi modelul pe [Hugging Face Hub](https://huggingface.co/models)

+

+## Cerințe Prealabile

+

+Pentru a obține cel mai mult din acest capitol, este util să ai:

+- Înțelegere solidă a programării Python

+- Familiaritate cu conceptele de machine learning

+- Interes pentru AI și modelele de limbaj

+

+Nu-ți face griji dacă îți lipsesc unele dintre acestea – vom explica conceptele cheie pe măsură ce mergem! 🚀

+

+

+

+Dacă nu ai toate cerințele prealabile, consultă acest [curs](/course/chapter1/1) de la unitățile 1 la 11

+

+

+

+## Cum să Folosești Acest Capitol

+

+1. **Citește Secvențial**: Secțiunile se construiesc una pe alta, așa că este mai bine să le citești în ordine

+2. **Partajează Notițe**: Scrie conceptele cheie și întrebările și discută-le cu comunitatea în [Discord](https://discord.gg/F3vZujJH)

+3. **Încearcă Codul**: Când ajungem la exemplele practice, încearcă-le singur

+4. **Alătură-te Comunității**: Folosește resursele pe care le oferim pentru a te conecta cu alți cursanți

+

+Să începem explorarea Open R1 și să descoperim cum poți fi parte din a face AI-ul mai accesibil pentru toată lumea! 🚀

\ No newline at end of file

diff --git a/chapters/rum/chapter12/2.mdx b/chapters/rum/chapter12/2.mdx

new file mode 100644

index 000000000..fc76264eb

--- /dev/null

+++ b/chapters/rum/chapter12/2.mdx

@@ -0,0 +1,245 @@

+# Introducere în Învățarea prin Întărire și rolul acesteia în LLM-uri

+

+Bun venit la prima pagină!

+

+Vom începe călătoria noastră în lumea captivantă a Învățării prin Întărire (RL) și vom descoperi cum aceasta revoluționează modul în care antrenăm Modelele de Limbaj precum cele pe care le-ai putea folosi în fiecare zi.

+

+

+

+În acest capitol, ne concentrăm pe învățarea prin întărire pentru modelele de limbaj. Cu toate acestea, învățarea prin întărire este un domeniu larg cu multe aplicații dincolo de modelele de limbaj. Dacă ești interesat să înveți mai multe despre învățarea prin întărire, ar trebui să consulți [Cursul de Învățare prin Întărire Profundă](https://huggingface.co/courses/deep-rl-course/en/unit1/introduction).

+

+

+

+Această pagină îți va oferi o introducere prietenoasă și clară în RL, chiar dacă nu ai întâlnit-o niciodată înainte. Vom descompune ideile principale și vom vedea de ce RL devine atât de important în domeniul Modelelor Mari de Limbaj (LLM-uri).

+

+## Ce este Învățarea prin Întărire (RL)?

+

+Imaginează-ți că antrenezi un câine. Vrei să-l înveți să stea. Ai putea spune "Stai!" și apoi, dacă câinele stă, îi dai o recompensă și îl lauzi. Dacă nu stă, ai putea să-l ghidezi blând sau doar să încerci din nou. De-a lungul timpului, câinele învață să asocieze statul cu recompensa pozitivă (recompensa și lauda) și este mai probabil să stea când spui "Stai!" din nou. În învățarea prin întărire, ne referim la acest feedback ca **recompensă**.

+

+Aceasta, pe scurt, este ideea de bază din spatele Învățării prin Întărire! În loc de un câine, avem un **model de limbaj** (în învățarea prin întărire, îl numim **agent**), și în loc de tine, avem **mediul** care oferă feedback.

+

+

+

+Să descompunem elementele cheie ale RL:

+

+### Agent

+

+Acesta este cel care învață. În exemplul cu câinele, câinele este agentul. În contextul LLM-urilor, LLM-ul însuși devine agentul pe care vrem să-l antrenăm. Agentul este cel care ia decizii și învață din mediu și din recompensele sale.

+

+### Mediu

+

+Acesta este lumea în care trăiește și interacționează agentul. Pentru câine, mediul este casa ta și tu. Pentru un LLM, mediul este puțin mai abstract – ar putea fi utilizatorii cu care interacționează, sau un scenariu simulat pe care îl configurăm pentru el. Mediul oferă feedback agentului.

+

+### Acțiune

+

+Acestea sunt alegerile pe care agentul le poate face în mediu. Acțiunile câinelui sunt lucruri precum "stai", "ridică-te", "latră", etc. Pentru un LLM, acțiunile ar putea fi generarea de cuvinte într-o propoziție, alegerea ce răspuns să dea la o întrebare, sau deciderea cum să răspundă într-o conversație.

+

+### Recompensă

+

+Acesta este feedback-ul pe care mediul îl oferă agentului după ce acesta întreprinde o acțiune. Recompensele sunt de obicei numere.

+

+**Recompensele pozitive** sunt ca recompensele și laudele – îi spun agentului "bună treabă, ai făcut ceva corect!".

+

+**Recompensele negative** (sau penalitățile) sunt ca un "nu" blând – îi spun agentului "nu a fost tocmai corect, încearcă altceva". Pentru câine, recompensa este răsplata.

+

+Pentru un LLM, recompensele sunt concepute să reflecte cât de bine se descurcă LLM-ul la o sarcină specifică – poate fi cât de util, adevărat sau inofensiv este răspunsul său.

+

+### Politică

+

+Aceasta este strategia agentului pentru alegerea acțiunilor. Este ca înțelegerea câinelui despre ce ar trebui să facă când spui "Stai!". În RL, politica este ceea ce încercăm cu adevărat să învățăm și să îmbunătățim. Este un set de reguli sau o funcție care îi spune agentului ce acțiune să întreprindă în diferite situații. Inițial, politica ar putea fi aleatorie, dar pe măsură ce agentul învață, politica devine mai bună la alegerea acțiunilor care duc la recompense mai mari.

+

+## Procesul RL: Încercări și Erori

+

+

+

+Învățarea prin Întărire se întâmplă printr-un proces de încercări și erori:

+

+| Pas | Proces | Descriere |

+|------|---------|-------------|

+| 1. Observație | Agentul observă mediul | Agentul preia informații despre starea sa actuală și împrejurimile |

+| 2. Acțiune | Agentul întreprinde o acțiune bazată pe politica sa actuală | Folosind strategia sa învățată (politica), agentul decide ce să facă în continuare |

+| 3. Feedback | Mediul îi oferă agentului o recompensă | Agentul primește feedback despre cât de bună sau rea a fost acțiunea sa |

+| 4. Învățare | Agentul își actualizează politica bazată pe recompensă | Agentul își ajustează strategia - întărind acțiunile care au dus la recompense mari și evitând pe cele care au dus la recompense mici |

+| 5. Iterație | Repetă procesul | Acest ciclu continuă, permițând agentului să-și îmbunătățească continuu luarea deciziilor |

+

+Gândește-te la învățarea mersului pe bicicletă. Ai putea să te legeni și să cazi la început (recompensă negativă!). Dar când reușești să te echilibrezi și să pedalezi lin, te simți bine (recompensă pozitivă!). Îți ajustezi acțiunile bazat pe acest feedback – înclinându-te puțin, pedalând mai repede, etc. – până când înveți să mergi bine. RL este similar – se referă la învățarea prin interacțiune și feedback.

+

+## Rolul RL în Modelele Mari de Limbaj (LLM-uri)

+

+Acum, de ce este RL atât de important pentru Modelele Mari de Limbaj?

+

+Ei bine, antrenarea LLM-urilor cu adevărat bune este complicată. Le putem antrena pe cantități masive de text de pe internet, și devin foarte bune la prezicerea următorului cuvânt într-o propoziție. Astfel învață să genereze text fluent și corect din punct de vedere gramatical, după cum am învățat în [capitolul 2](/course/chapter2/1).

+

+Cu toate acestea, a fi doar fluent nu este suficient. Vrem ca LLM-urile noastre să fie mai mult decât bune la înșiruirea cuvintelor. Vrem ca ele să fie:

+

+* **Utile:** Să ofere informații utile și relevante.

+* **Inofensive:** Să evite generarea de conținut toxic, părtinitor sau dăunător.

+* **Aliniate cu Preferințele Umane:** Să răspundă în moduri pe care oamenii le găsesc naturale, utile și captivante.

+

+Metodele de pre-antrenare LLM, care se bazează în principal pe prezicerea următorului cuvânt din datele text, uneori nu reușesc în aceste aspecte.

+

+În timp ce antrenamentul supervizat este excelent la producerea de rezultate structurate, poate fi mai puțin eficient la producerea de răspunsuri utile, inofensive și aliniate. Explorăm antrenamentul supervizat în [capitolul 11](/course/chapter11/1).

+

+Modelele ajustate fin ar putea genera text fluent și structurat care este încă factual incorect, părtinitor, sau nu răspunde cu adevărat la întrebarea utilizatorului într-un mod util.

+

+**Intră Învățarea prin Întărire!** RL ne oferă o modalitate de a ajusta fin aceste LLM-uri pre-antrenate pentru a atinge mai bine aceste calități dorite. Este ca să-i dai câinelui nostru LLM antrenament suplimentar pentru a deveni un companion bine comportat și util, nu doar un câine care știe să latre fluent!

+

+## Învățarea prin Întărire din Feedback Uman (RLHF)

+

+O tehnică foarte populară pentru alinierea modelelor de limbaj este **Învățarea prin Întărire din Feedback Uman (RLHF)**. În RLHF, folosim feedback-ul uman ca proxy pentru semnalul de "recompensă" în RL. Iată cum funcționează:

+

+1. **Obține Preferințe Umane:** Am putea cere oamenilor să compare diferite răspunsuri generate de LLM pentru aceeași intrare și să ne spună ce răspuns preferă. De exemplu, am putea arăta unui om două răspunsuri diferite la întrebarea "Care este capitala Franței?" și să îl întrebăm "Care răspuns este mai bun?".

+

+2. **Antrenează un Model de Recompensă:** Folosim aceste date de preferință umană pentru a antrena un model separat numit **model de recompensă**. Acest model de recompensă învață să prezică ce fel de răspunsuri vor prefera oamenii. Învață să evalueze răspunsurile bazat pe utilitate, inofensivitate și alinierea cu preferințele umane.

+

+3. **Ajustează fin LLM-ul cu RL:** Acum folosim modelul de recompensă ca mediu pentru agentul nostru LLM. LLM-ul generează răspunsuri (acțiuni), și modelul de recompensă evaluează aceste răspunsuri (oferă recompense). În esență, antrenăm LLM-ul să producă text pe care modelul nostru de recompensă (care a învățat din preferințele umane) îl consideră bun.

+

+

+

+Dintr-o perspectivă generală, să privim beneficiile folosirii RL în LLM-uri:

+

+| Beneficiu | Descriere |

+|---------|-------------|

+| Control Îmbunătățit | RL ne permite să avem mai mult control asupra tipului de text pe care îl generează LLM-urile. Le putem ghida să producă text care este mai aliniat cu obiective specifice, cum ar fi a fi util, creativ sau concis. |

+| Alinierea Îmbunătățită cu Valorile Umane | RLHF, în particular, ne ajută să aliniată LLM-urile cu preferințele umane complexe și adesea subiective. Este greu să scrii reguli pentru "ce face un răspuns bun," dar oamenii pot judeca și compara ușor răspunsurile. RLHF permite modelului să învețe din aceste judecăți umane. |

+| Reducerea Comportamentelor Nedorite | RL poate fi folosit pentru a reduce comportamentele negative în LLM-uri, cum ar fi generarea de limbaj toxic, răspândirea dezinformării sau exhibarea prejudecăților. Prin conceperea recompenselor care penalizează aceste comportamente, putem îndemna modelul să le evite. |

+

+Învățarea prin Întărire din Feedback Uman a fost folosită pentru a antrena multe dintre cele mai populare LLM-uri de astăzi, cum ar fi GPT-4 de la OpenAI, Gemini de la Google și R1 de la DeepSeek. Există o gamă largă de tehnici pentru RLHF, cu grade variate de complexitate și sofisticare. În acest capitol, ne vom concentra pe Optimizarea Relativă a Politicii de Grup (GRPO), care este o tehnică pentru RLHF care s-a dovedit eficientă la antrenarea LLM-urilor care sunt utile, inofensive și aliniate cu preferințele umane.

+

+## De ce ar trebui să ne pese de GRPO (Optimizarea Relativă a Politicii de Grup)?

+

+Există multe tehnici pentru RLHF, dar acest curs se concentrează pe GRPO pentru că reprezintă un progres semnificativ în învățarea prin întărire pentru modelele de limbaj.

+

+Să considerăm pe scurt două dintre celelalte tehnici populare pentru RLHF:

+

+- Optimizarea Politicii Proximale (PPO)

+- Optimizarea Directă a Preferinței (DPO)

+

+Optimizarea Politicii Proximale (PPO) a fost una dintre primele tehnici foarte eficiente pentru RLHF. Folosește o metodă de gradient de politică pentru a actualiza politica bazată pe recompensa de la un model de recompensă separat.

+

+Optimizarea Directă a Preferinței (DPO) a fost dezvoltată mai târziu ca o tehnică mai simplă care elimină nevoia unui model de recompensă separat folosind datele de preferință direct. În esență, încadrează problema ca o sarcină de clasificare între răspunsurile alese și respinse.

+

+

+

+DPO și PPO sunt algoritmi complecși de învățare prin întărire în sine, pe care nu îi vom acoperi în acest curs. Dacă ești interesat să înveți mai multe despre ei, poți consulta următoarele resurse:

+

+- [Optimizarea Politicii Proximale](https://huggingface.co/docs/trl/main/en/ppo_trainer)

+- [Optimizarea Directă a Preferinței](https://huggingface.co/docs/trl/main/en/dpo_trainer)

+

+

+