[CLS] la început, dar nu este singurul lucru necesar!"

+ },

+ {

+ text: "[CLS] Tokens_of_sentence_1 [SEP] Tokens_of_sentence_2 [SEP]",

+ explain: "Corect!",

+ correct: true

+ },

+ {

+ text: "[CLS] Tokens_of_sentence_1 [SEP] Tokens_of_sentence_2",

+ explain: "Este nevoie atât de un token special [CLS] la început, cât și de un token special [SEP] pentru a separa cele două propoziții, dar mai lipsește ceva!"

+ }

+ ]}

+/>

+

+{#if fw === 'pt'}

+### 4. Care sunt avantajele metodei `Dataset.map()`?

+

+DataLoader. Am folosit funcția DataCollatorWithPadding, care împachetează toate elementele dintr-un batch astfel încât să aibă aceeași lungime.",

+ correct: true

+ },

+ {

+ text: "Preprocesează întregul set de date.",

+ explain: "Aceasta ar fi o funcție de preprocessing, nu o funcție de collate."

+ },

+ {

+ text: "Trunchiază secvențele din setul de date.",

+ explain: "O funcție de collate se ocupă de manipularea batch-urilor individuale, nu a întregului set de date. Dacă sunteți interesați de trunchiere, puteți folosi argumentul truncate al tokenizer."

+ }

+ ]}

+/>

+

+### 7. Ce se întâmplă când instanțiați una dintre clasele `AutoModelForXxx` cu un model de limbaj preantrenat (cum ar fi `bert-base-uncased`), care corespunde unei alte sarcini decât cea pentru care a fost antrenat?

+

+bert-base-uncased, am primit avertismente la instanțierea modelului. Head-ul preantrenat nu este folosit pentru sarcina de clasificare secvențială, așa că este eliminat și un nou head este instanțiat cu greutăți inițializate aleator.",

+ correct: true

+ },

+ {

+ text: "Head-ul modelului preantrenat este eliminat.",

+ explain: "Mai trebuie să se întâmple și altceva. Încercați din nou!"

+ },

+ {

+ text: "Nimic, pentru că modelul poate fi ajustat fin (fine-tuned) chiar și pentru o altă sarcină.",

+ explain: "Head-ul preantrenat al modelului nu a fost antrenat pentru această sarcină, deci trebuie eliminat!"

+ }

+ ]}

+/>

+

+### 8. Care este scopul folosirii `TrainingArguments`?

+

+TrainingArguments."

+ },

+ {

+ text: "Conține doar hiperparametrii folosiți pentru evaluare.",

+ explain: "În exemplu, am specificat și unde va fi salvat modelul și checkpoint-urile. Încercați din nou!"

+ },

+ {

+ text: "Conține doar hiperparametrii folosiți pentru antrenare.",

+ explain: "În exemplu, am folosit și un evaluation_strategy, așadar acest lucru afectează evaluarea. Încercați din nou!"

+ }

+ ]}

+/>

+

+### 9. De ce ar trebui să folosiți biblioteca 🤗 Accelerate?

+

+bert-base-uncased, am primit avertismente la instanțierea modelului. Head-ul preantrenat nu este folosit pentru sarcina de clasificare secvențială, așa că este eliminat și un nou head este instanțiat cu greutăți inițializate aleator.",

+ correct: true

+ },

+ {

+ text: "Head-ul modelului preantrenat este eliminat.",

+ explain: "Mai trebuie să se întâmple și altceva. Încercați din nou!"

+ },

+ {

+ text: "Nimic, pentru că modelul poate fi ajustat fin (fine-tuned) chiar și pentru o altă sarcină.",

+ explain: "Head-ul preantrenat al modelului nu a fost antrenat pentru această sarcină, deci trebuie eliminat!"

+ }

+ ]}

+/>

+

+### 5. Modelele TensorFlow din `transformers` sunt deja modele Keras. Ce avantaj oferă acest lucru?

+

+compile(), fit() și predict().",

+ explain: "Corect! Odată ce aveți datele, antrenarea necesită foarte puțin efort.",

+ correct: true

+ },

+ {

+ text: "Învățați atât Keras, cât și transformers.",

+ explain: "Corect, dar căutăm altceva :)",

+ correct: true

+ },

+ {

+ text: "Puteți calcula cu ușurință metrici legate de dataset.",

+ explain: "Keras ne ajută la antrenarea și evaluarea modelului, nu la calcularea metricilor legate de dataset."

+ }

+ ]}

+/>

+

+### 6. Cum vă puteți defini propria metrică personalizată?

+

+metric_fn(y_true, y_pred).",

+ explain: "Corect!",

+ correct: true

+ },

+ {

+ text: "Căutând pe Google.",

+ explain: "Nu este răspunsul pe care îl căutăm, dar probabil v-ar putea ajuta să-l găsiți.",

+ correct: true

+ }

+ ]}

+/>

+

+{/if}

\ No newline at end of file

diff --git a/chapters/rum/chapter4/1.mdx b/chapters/rum/chapter4/1.mdx

new file mode 100644

index 000000000..4ef56abf4

--- /dev/null

+++ b/chapters/rum/chapter4/1.mdx

@@ -0,0 +1,22 @@

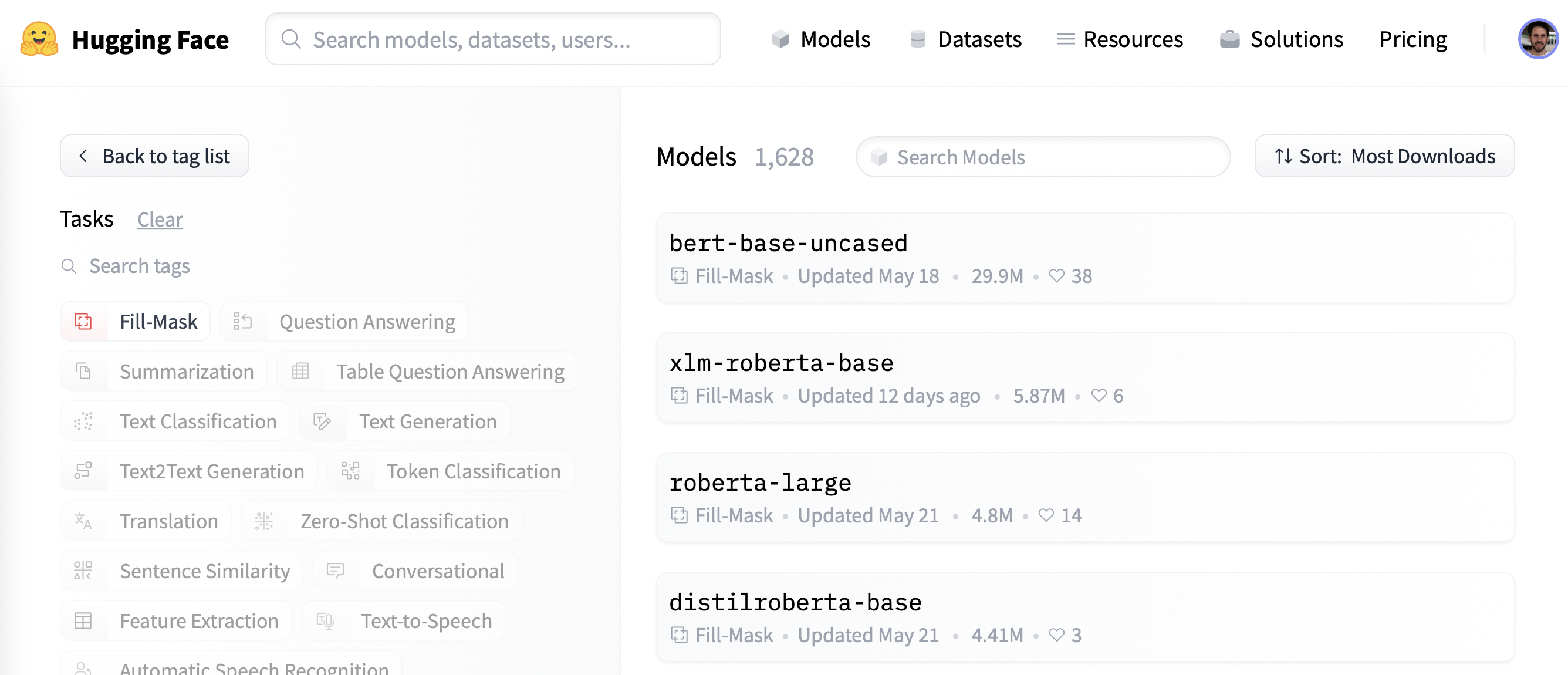

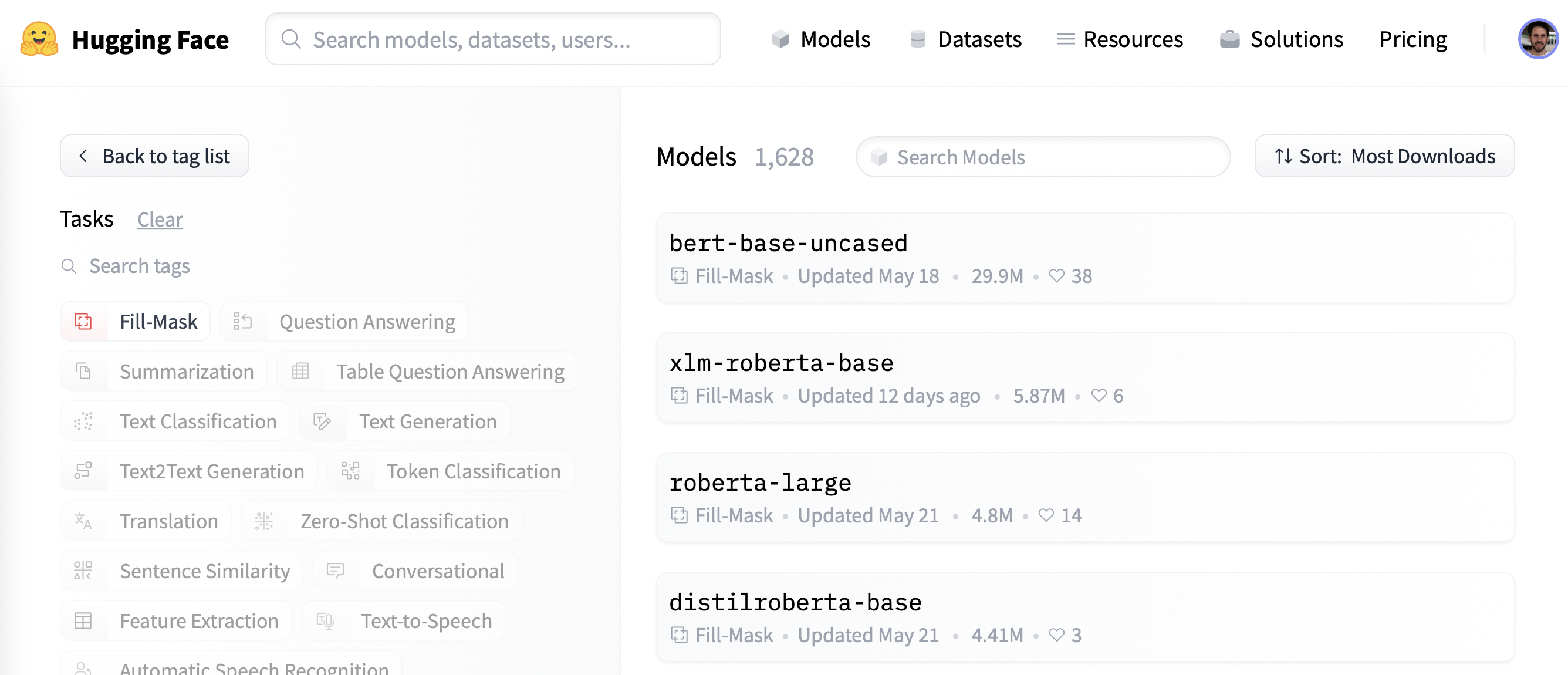

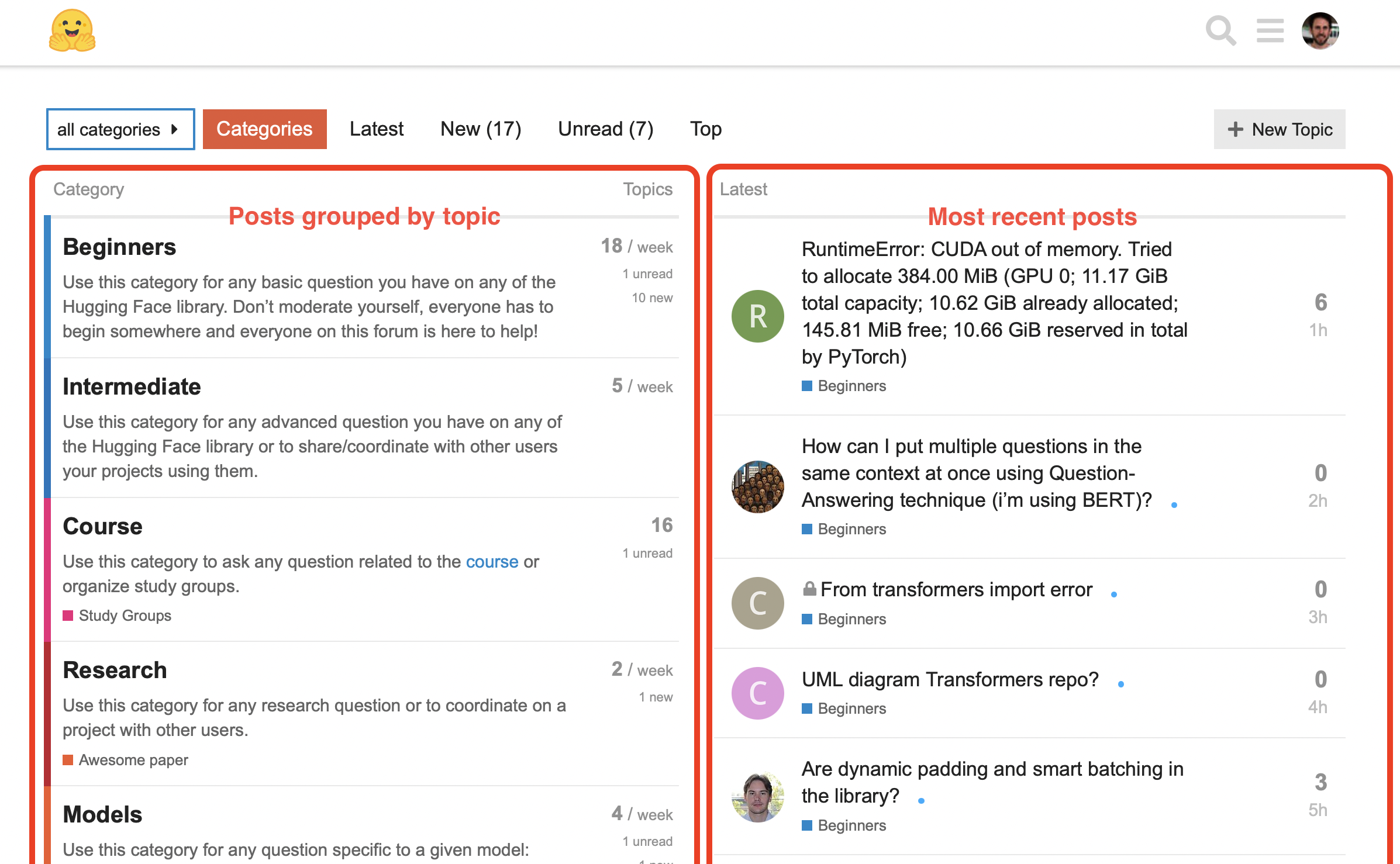

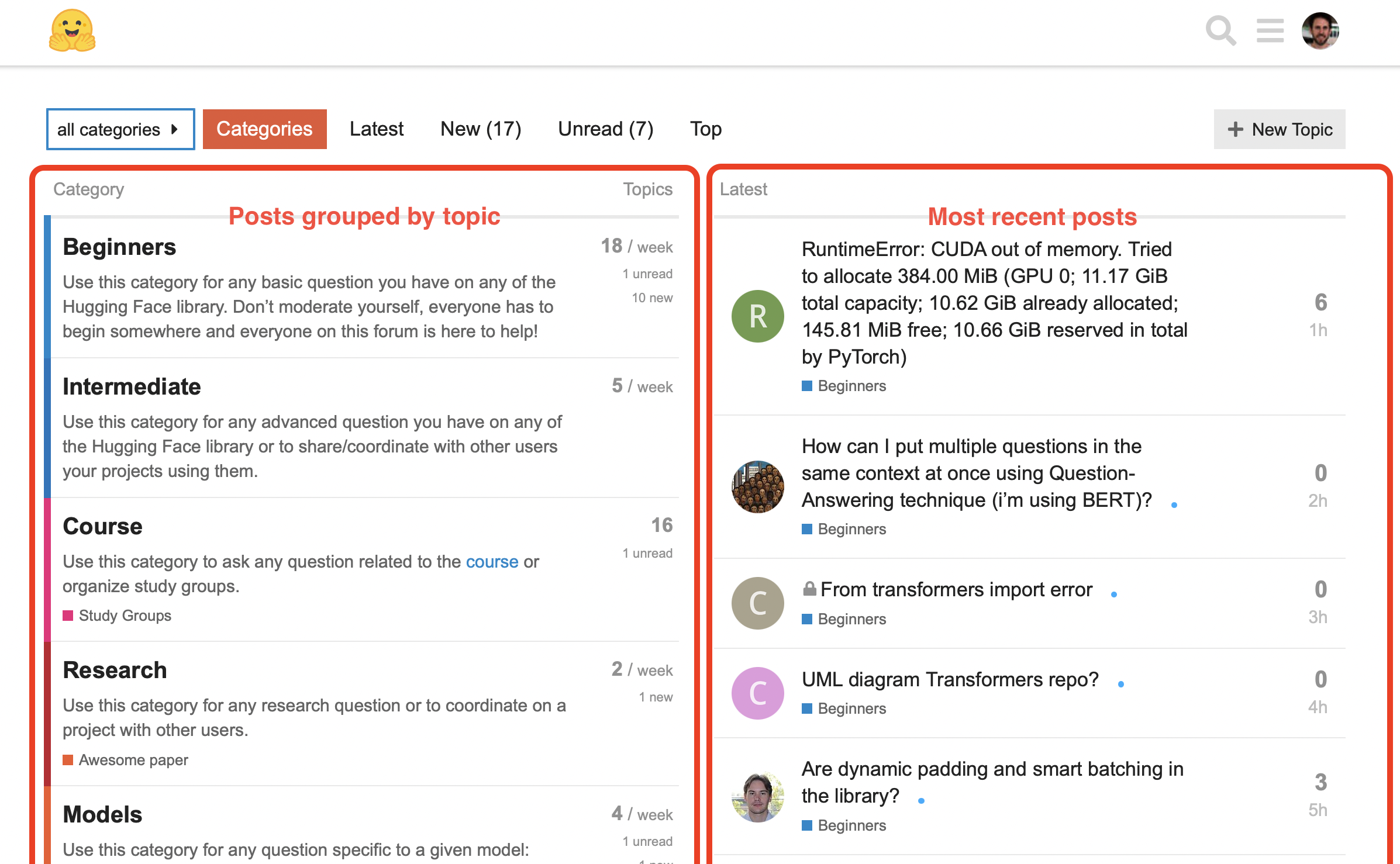

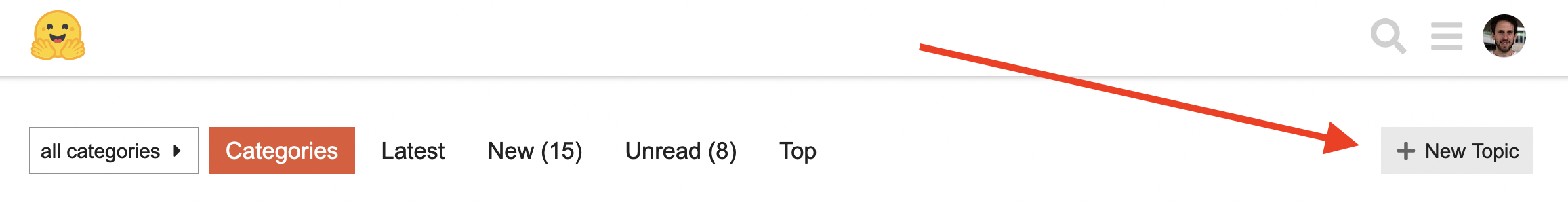

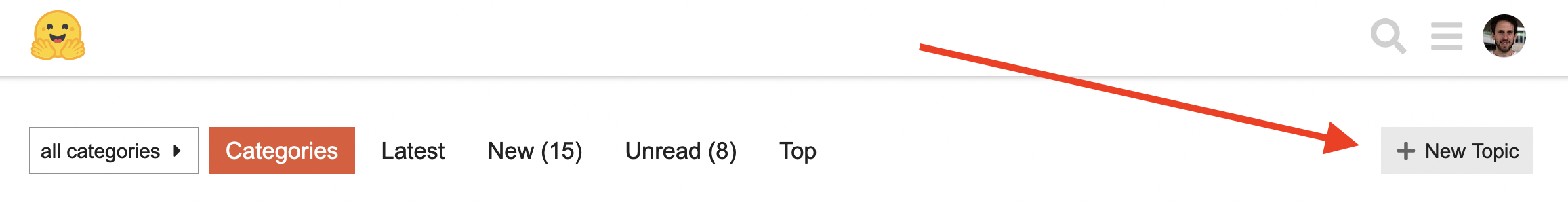

+# Platforma Hugging Face Hub[[the-hugging-face-hub]]

+

+

+ +

+

+

+Alegem checkpointul „camembert-base” pentru al încerca. Identificatorul `camembert-base` este tot de ce avem nevoie pentru a începe. În capitolele precedente, am văzut cum putem inițializa modelul folosind funcția `pipeline()`:

+

+```py

+from transformers import pipeline

+

+camembert_fill_mask = pipeline("fill-mask", model="camembert-base")

+results = camembert_fill_mask("Le camembert est  +

+

+ +

+

+

+Puteți inițializa checkpointul în mod direct folosind arhitectura modelului:

+

+{#if fw === 'pt'}

+```py

+from transformers import CamembertTokenizer, CamembertForMaskedLM

+

+tokenizer = CamembertTokenizer.from_pretrained("camembert-base")

+model = CamembertForMaskedLM.from_pretrained("camembert-base")

+```

+

+Însă, recomandăm utilizarea [claselor `Auto*`](https://huggingface.co/transformers/model_doc/auto?highlight=auto#auto-classes), deoarece acestea sunt proiectate să fie architecture-agnostic. În timp ce codul precedent limita utilizatorii la checkpoints loadable în CamemBERT architecture, utilizarea claselor `Auto*` face schimbarea checkpointurilor simplă:

+

+```py

+from transformers import AutoTokenizer, AutoModelForMaskedLM

+

+tokenizer = AutoTokenizer.from_pretrained("camembert-base")

+model = AutoModelForMaskedLM.from_pretrained("camembert-base")

+```

+{:else}

+```py

+from transformers import CamembertTokenizer, TFCamembertForMaskedLM

+

+tokenizer = CamembertTokenizer.from_pretrained("camembert-base")

+model = TFCamembertForMaskedLM.from_pretrained("camembert-base")

+```

+

+Însă, recomandăm utilizarea [claselor `TFAuto*`](https://huggingface.co/transformers/model_doc/auto?highlight=auto#auto-classes), deoarece acestea sunt proiectate să fie architecture-agnostic. În timp ce codul precedent limita utilizatorii la checkpoints loadable în CamemBERT architecture, utilizarea claselor `TFAuto*` face schimbarea checkpointurilor simplă:

+

+```py

+from transformers import AutoTokenizer, TFAutoModelForMaskedLM

+

+tokenizer = AutoTokenizer.from_pretrained("camembert-base")

+model = TFAutoModelForMaskedLM.from_pretrained("camembert-base")

+```

+{/if}

+

+ +

+

+  +

+

+

+{:else}

+

+Dacă utilizați Keras pentru a antrena modelul dumneavoastră, cea mai ușoară modalitate de a încărca-o pe Hub este să transmiteți un `PushToHubCallback` când chemați `model.fit()`:

+

+```py

+from transformers import PushToHubCallback

+

+callback = PushToHubCallback(

+ "bert-finetuned-mrpc", save_strategy="epoch", tokenizer=tokenizer

+)

+```

+

+Apoi, adăugați `callbacks=[callback]` în apelul la `model.fit()`. Callback-ul va încărca apoi modelul pe Hub de fiecare dată când se salvează (aici, la fiecare epocă) într-un repository din namespace-ul tău. Acest repository va fi numit după output directory ales (aici `bert-finetuned-mrpc`), dar puteți alege un alt nume cu `hub_model_id = "un_nume_diferit"`.

+

+Pentru a încărca modelul într-o organizație din care faceți parte, este suficient să introduceți aceasta în `hub_model_id = "organizația_mea/numele_repositoriului"`.

+

+{/if}

+

+La un nivel inferior, accesarea Hub-ului se poate face direct pe modele, tokenizers și configurations objects prin metoda `push_to_hub()`. Această metodă se ocupă atât de crearea repositoriului cât si de încărcarea modelului și tokenizerului direct în el. Nu este nevoie de o interacțiune manuală, precum fața de API-ul pe care îl vom vedea mai jos.

+

+Pentru a înțelege cum funcționează, luați în considerare inițializarea unui model și a unui tokenizer:

+

+{#if fw === 'pt'}

+```py

+from transformers import AutoModelForMaskedLM, AutoTokenizer

+

+checkpoint = "camembert-base"

+

+model = AutoModelForMaskedLM.from_pretrained(checkpoint)

+tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+```

+{:else}

+```py

+from transformers import TFAutoModelForMaskedLM, AutoTokenizer

+

+checkpoint = "camembert-base"

+

+model = TFAutoModelForMaskedLM.from_pretrained(checkpoint)

+tokenizer = AutoTokenizer.from_pretrained(checkpoint)

+```

+{/if}

+

+Sunteți liberi să faceți orice ați vrea cu acestea - adăugați tokens la tokenizer, antrenați modelul sau faceți fine-tune. Odată ce sunteți mulțumiți de modelul obținut, weighturile și tokenizerul acestuia , puteți folosi metoda `push_to_hub()` disponibilă direct pe obiectul `model`:

+

+```py

+model.push_to_hub("dummy-model")

+```

+Acest lucru va crea un nou repository `dummy-model` în profilul tău și o va popula cu fișierele modelului tău.

+Încercați același lucru cu tokenizerul, astfel încât toate fișierele să fie acum disponibile în acest repository:

+

+```py

+tokenizer.push_to_hub("dummy-model")

+```

+

+Dacă aparțineți unei organizații, specificați doar argumentul `organization` pentru a încărca în namespace-ul acestei organizații:

+

+```py

+tokenizer.push_to_hub("dummy-model", organization="huggingface")

+```

+

+Dacă doriți să utilizați un anumit token Hugging Face, sunteți liberi să specificați acest lucru metodei `push_to_hub()`:

+

+```py

+tokenizer.push_to_hub("dummy-model", organization="huggingface", use_auth_token=" +

+

+ +

+

+{:else}

+ +

+

+ +

+

+{/if}

+

+ +

+

+ +

+

+

+În primul rând, specificați deținătorul repositoriului: acesta puteți fi fie dumneavoastră, fie orice organizație cu care sunteți afiliat. Dacă alegeți o organizație, modelul va fi prezent pe pagina organizației și toți membrii acesteia vor avea posibilitatea să contribuie la repositoriu.

+

+În al doilea rând, introduceți numele modelului dumneavoastră. Acest lucru va fi și denumirea repositoriului. În final, puteți specifica dacă doriți ca modelul dumneavoastră să fie public sau privat. Modelele private nu sunt vizibile ceilorlalți.

+

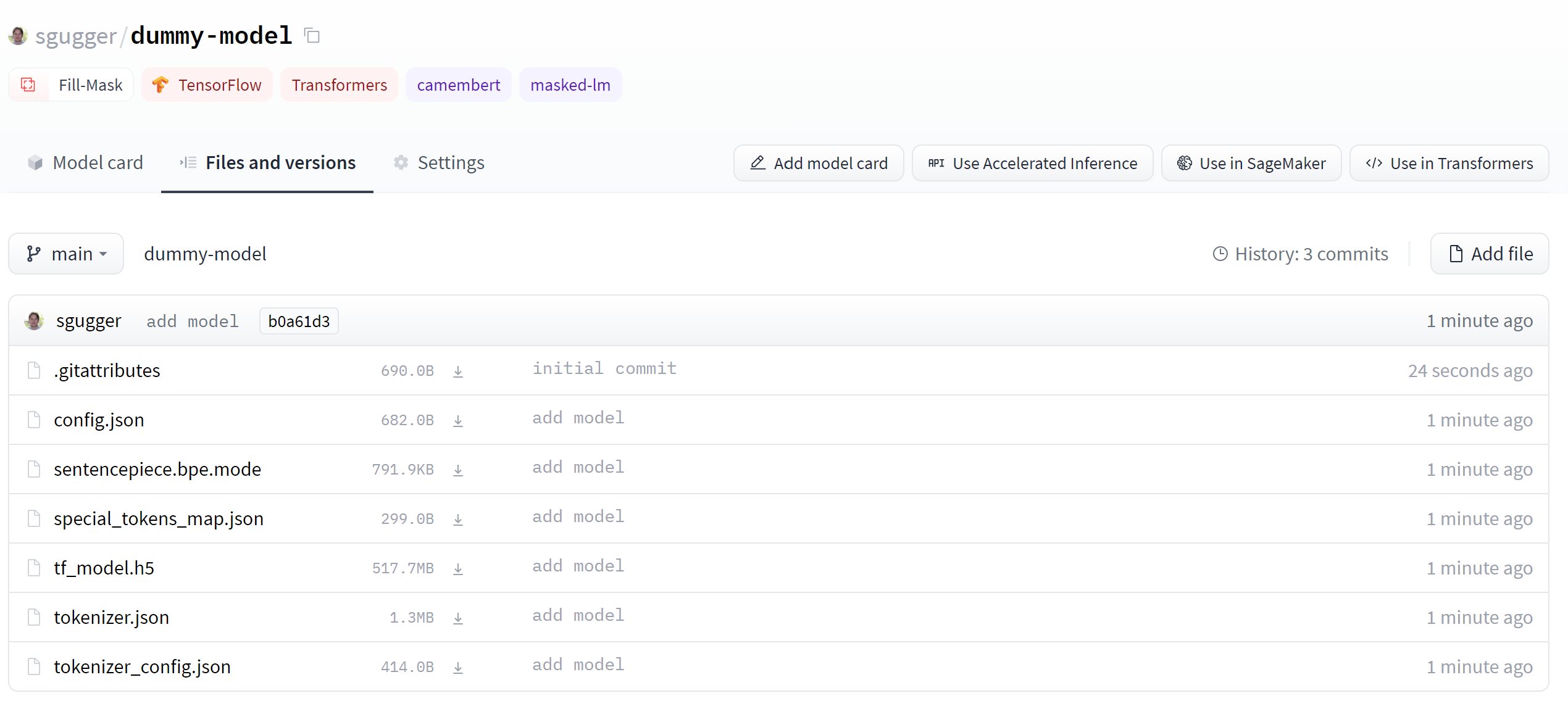

+După crearea repositoriului, ar trebui să vedeți o pagină ca aceasta:

+

+ +

+

+ +

+

+

+Acesta este locul unde va fi găzduit modelul. Pentru a începe să populați acesta, puteți adăuga un fișier README direct din interfața web.

+

+ +

+

+ +

+

+

+Fișierul README este scris în format Markdown - vă rugăm să fiți creativi cu el! A treia parte a acestui capitol se ocupă de crearea unui model card. Acestea sunt foarte importante pentru a aduce valoare modelului dumneavoastră, deoarece este acolo unde spuneți celorlalți ce poate face.

+

+Dacă vă uitați la secțiunea "Fișiere și versiuni", veți vedea că nu sunt prea multe fișiere acolo încă - doar *README.md* pe care l-ați creat dumneavoastră și *.gitattributes* care urmărește fișierele mari.

+

+ +

+

+ +

+

+

+Vom vedea mai târziu cum să adăugați câteva fișiere noi.

+

+## Încărcarea fișierelor modelului[[uploading-the-model-files]]

+

+Sistemul pentru a gestiona fișierele în Hugging Face Hub se bazează pe git pentru fișierele obișnuite, și pe git-lfs (care se descrifrează ca [Git Large File Storage](https://git-lfs.github.com/)) pentru fișierele mai mari.

+

+În secțiunea următoare, vom discuta despre trei metode diferite de încărcare a fișierelor în Hub: prin `huggingface_hub` și prin comanda git.

+

+### Metoda `upload_file`[[the-uploadfile-approach]]

+

+Prin `upload_file` nu este necesar să instalați git și git-lfs pe sistemul dumneavoastră. Acest lucru încarcă direct fișierele în 🤗 Hub folosind HTTP POST requests. O limitare a acestei metode este că ea nu se ocupă de fișiere care sunt mai mari de 5GB.

+Dacă fișierele dumneavoastră sunt mai mari decât 5 GB, vă rugăm să urmați celelalte două metode descrise mai jos.

+

+API-ul poate fi folosit astfel:

+

+```py

+from huggingface_hub import upload_file

+

+upload_file(

+ " +

+

+ +

+

+

+Interfața permite explorarea fișierelor modelului și a commiturilor și vizualizarea diferenței introduse de fiecare commit:

+

+ +

+

+ +

+

+{:else}

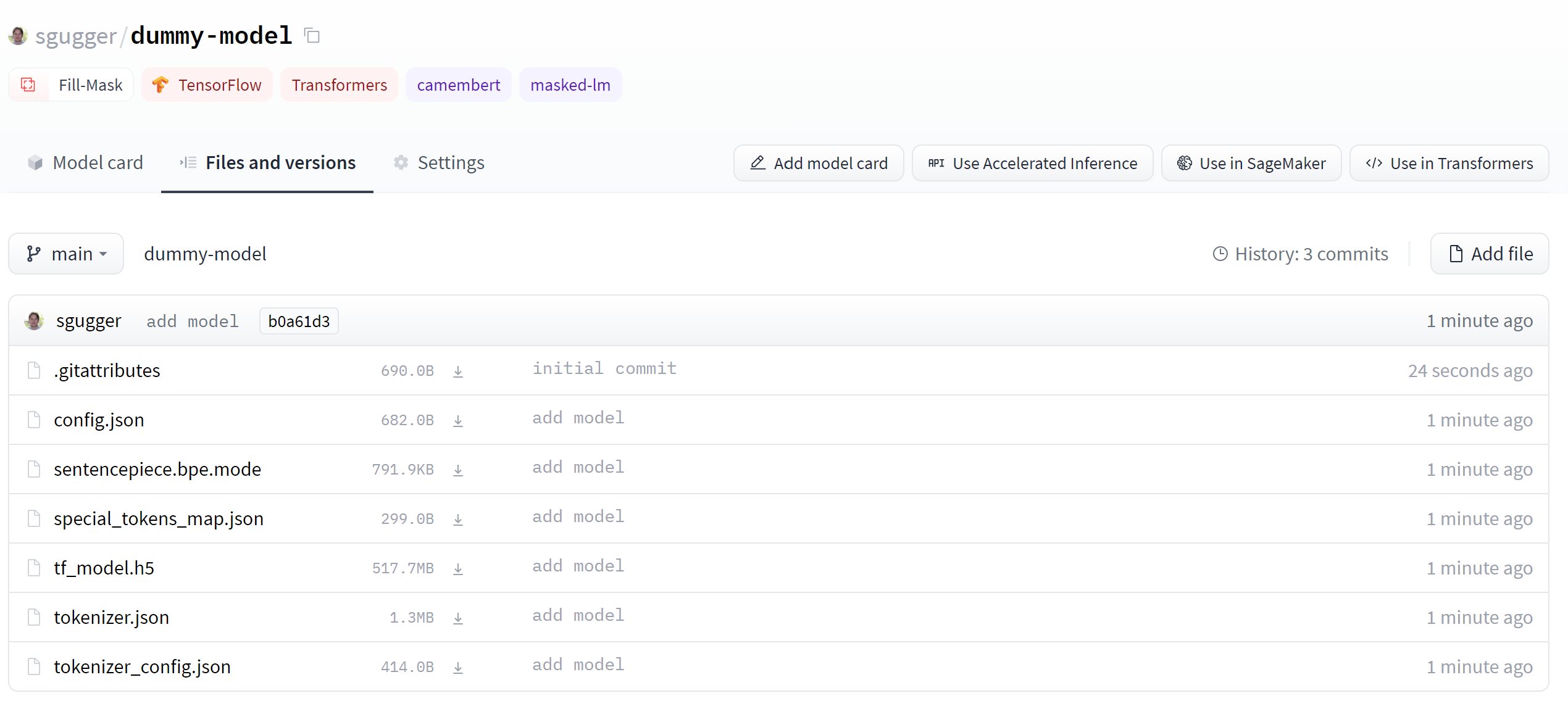

+Dacă ne uităm la repositoriul modelului când acest lucru este finalizat, putem vedea toate fișierele recent adăugate:

+

+ +

+

+ +

+

+

+Interfața permite explorarea fișierelor modelului și a commiturilor și vizualizarea diferenței introduse de fiecare commit:

+

+ +

+

+ +

+

+{/if}

diff --git a/chapters/rum/chapter4/4.mdx b/chapters/rum/chapter4/4.mdx

new file mode 100644

index 000000000..5615a1651

--- /dev/null

+++ b/chapters/rum/chapter4/4.mdx

@@ -0,0 +1,88 @@

+# Crearea unui card de model[[building-a-model-card]]

+

+

+ +

+push_to_hub, și utilizând-o, vor împărtăși configurația către un repo. Și ce altceva poți oferi?",

+ correct: true

+ },

+ {

+ text: "Un model",

+ explain: "Corect! Toate modelele au metoda push_to_hub, și utilizând-o, vor împărtăși ei, precum și fișierele de configurare către un repo. Și nu numai asta!",

+ correct: true

+ },

+ {

+ text: "Un Trainer",

+ explain: "Corect — Trainer implementează metoda push_to_hub, și utilizând-o, vor încărca modelul, configurarea sa, tokenizerul, precum și un draft a unui model card către un repo. Încearcă și altă opțiune!",

+ correct: true

+ }

+ ]}

+/>

+

+{:else}

+push_to_hub, și utilizând-o, vor împărtăși configurația către un repo. Și ce altceva poți oferi?",

+ correct: true

+ },

+ {

+ text: "Un model",

+ explain: "Corect! Toate modelele au metoda push_to_hub, și utilizând-o, vor împărtăși ei, precum și fișierele de configurare către un repo. Și nu numai asta!",

+ correct: true

+ },

+ {

+ text: "Toate cele trei cu un callback dedicat",

+ explain: "Corect — PushToHubCallback va trimite regular toate aceste obiecte către un repo în timpul antrenării.",

+ correct: true

+ }

+ ]}

+/>

+{/if}

+

+### 6. Care este primul pas atunci când utilizați metoda `push_to_hub()` sau instrumentele CLI?

+

+huggingface_hub: nu vă trebuie nici un wrapping suplimentar!"

+ },

+ {

+ text: "Prin salvarea lor pe disc și apelarea transformers-cli upload-model",

+ explain: "Comanda upload-model nu există."

+ }

+ ]}

+/>

+

+### 8. Ce operații git poți face cu clasa `Repository`?

+

+git_pull()",

+ correct: true

+ },

+ {

+ text: "Un push",

+ explain: "Metoda git_push() face acest lucru.",

+ correct: true

+ },

+ {

+ text: "Un merge",

+ explain: "Nu, această operație nu va fi niciodată posibilă cu acest API."

+ }

+ ]}

+/>

\ No newline at end of file

diff --git a/chapters/rum/chapter5/1.mdx b/chapters/rum/chapter5/1.mdx

new file mode 100644

index 000000000..99ac985b9

--- /dev/null

+++ b/chapters/rum/chapter5/1.mdx

@@ -0,0 +1,22 @@

+# Introducere[[introduction]]

+

+| + | patient_id | +drugName | +condition | +review | +rating | +date | +usefulCount | +review_length | +

|---|---|---|---|---|---|---|---|---|

| 0 | +95260 | +Guanfacine | +adhd | +"My son is halfway through his fourth week of Intuniv..." | +8.0 | +April 27, 2010 | +192 | +141 | +

| 1 | +92703 | +Lybrel | +birth control | +"I used to take another oral contraceptive, which had 21 pill cycle, and was very happy- very light periods, max 5 days, no other side effects..." | +5.0 | +December 14, 2009 | +17 | +134 | +

| 2 | +138000 | +Ortho Evra | +birth control | +"This is my first time using any form of birth control..." | +8.0 | +November 3, 2015 | +10 | +89 | +

| + | condition | +frequency | +

|---|---|---|

| 0 | +birth control | +27655 | +

| 1 | +depression | +8023 | +

| 2 | +acne | +5209 | +

| 3 | +anxiety | +4991 | +

| 4 | +pain | +4744 | +

+ +

+

+

+Dacă ați da clic pe una dintre aceste issue-uri veți găsi că aceasta conține un titlu, o descriere și un set de labeluri care caracterizează issue-ul. Un exemplu este prezentat în screenshotul următor.

+

+ +

+

+ +

+

+

+Pentru a descărca toate issue-urile din repositoriu, vom folosi [GitHub REST API](https://docs.github.com/en/rest) pentru a enumera [`Issues` endpoint](https://docs.github.com/en/rest/reference/issues#list-repository-issues). Aceast endpoint returnează o listă de obiecte JSON, cu fiecare obiect conținând un număr mare de câmpuri care includ titlul și descrierea precum și metadata despre starea issue-ului și așa mai departe.

+

+Un mod convenabil de descărcare a issue-urilor este prin utilizarea librăriei `requests`, care este modalitatea standard pentru a face cereri HTTP în Python. Puteți instala libraria rulând comanda:

+

+```python

+!pip install requests

+```

+

+Odată cu instalarea librariei, puteți face cereri GET la `Issues` endpoint prin invocarea funcției `requests.get()`. De exemplu, puteți rula următorul cod pentru a obține primul issue din prima pagină:

+

+```py

+import requests

+

+url = "https://api.github.com/repos/huggingface/datasets/issues?page=1&per_page=1"

+response = requests.get(url)

+```

+

+Obiectul `response` conține o cantitate mare de informații utile despre requestul efectuat, inclusiv HTTP status code:

+

+```py

+response.status_code

+```

+

+```python out

+200

+```

+

+unde statusul `200` înseamnă că cererea a fost reușită (puteți găsi o listă completă de status coduri [aici](https://en.wikipedia.org/wiki/List_of_HTTP_status_codes)). De ceea ce suntem însă interesați este _payload_, care poate fi accesat în diverse formaturi precum bytes, string sau JSON. Deoarece știm că issue-urile noastre sunt în format JSON, să inspectăm payload-ul astfel:

+

+```py

+response.json()

+```

+

+```python out

+[{'url': 'https://api.github.com/repos/huggingface/datasets/issues/2792',

+ 'repository_url': 'https://api.github.com/repos/huggingface/datasets',

+ 'labels_url': 'https://api.github.com/repos/huggingface/datasets/issues/2792/labels{/name}',

+ 'comments_url': 'https://api.github.com/repos/huggingface/datasets/issues/2792/comments',

+ 'events_url': 'https://api.github.com/repos/huggingface/datasets/issues/2792/events',

+ 'html_url': 'https://github.com/huggingface/datasets/pull/2792',

+ 'id': 968650274,

+ 'node_id': 'MDExOlB1bGxSZXF1ZXN0NzEwNzUyMjc0',

+ 'number': 2792,

+ 'title': 'Update GooAQ',

+ 'user': {'login': 'bhavitvyamalik',

+ 'id': 19718818,

+ 'node_id': 'MDQ6VXNlcjE5NzE4ODE4',

+ 'avatar_url': 'https://avatars.githubusercontent.com/u/19718818?v=4',

+ 'gravatar_id': '',

+ 'url': 'https://api.github.com/users/bhavitvyamalik',

+ 'html_url': 'https://github.com/bhavitvyamalik',

+ 'followers_url': 'https://api.github.com/users/bhavitvyamalik/followers',

+ 'following_url': 'https://api.github.com/users/bhavitvyamalik/following{/other_user}',

+ 'gists_url': 'https://api.github.com/users/bhavitvyamalik/gists{/gist_id}',

+ 'starred_url': 'https://api.github.com/users/bhavitvyamalik/starred{/owner}{/repo}',

+ 'subscriptions_url': 'https://api.github.com/users/bhavitvyamalik/subscriptions',

+ 'organizations_url': 'https://api.github.com/users/bhavitvyamalik/orgs',

+ 'repos_url': 'https://api.github.com/users/bhavitvyamalik/repos',

+ 'events_url': 'https://api.github.com/users/bhavitvyamalik/events{/privacy}',

+ 'received_events_url': 'https://api.github.com/users/bhavitvyamalik/received_events',

+ 'type': 'User',

+ 'site_admin': False},

+ 'labels': [],

+ 'state': 'open',

+ 'locked': False,

+ 'assignee': None,

+ 'assignees': [],

+ 'milestone': None,

+ 'comments': 1,

+ 'created_at': '2021-08-12T11:40:18Z',

+ 'updated_at': '2021-08-12T12:31:17Z',

+ 'closed_at': None,

+ 'author_association': 'CONTRIBUTOR',

+ 'active_lock_reason': None,

+ 'pull_request': {'url': 'https://api.github.com/repos/huggingface/datasets/pulls/2792',

+ 'html_url': 'https://github.com/huggingface/datasets/pull/2792',

+ 'diff_url': 'https://github.com/huggingface/datasets/pull/2792.diff',

+ 'patch_url': 'https://github.com/huggingface/datasets/pull/2792.patch'},

+ 'body': '[GooAQ](https://github.com/allenai/gooaq) dataset was recently updated after splits were added for the same. This PR contains new updated GooAQ with train/val/test splits and updated README as well.',

+ 'performed_via_github_app': None}]

+```

+

+Uau, aceasta e o cantitate mare de informație! Putem vedea câmpuri utile cum ar fi `title`, `body` și `number` care descriu problema, precum și informații despre utilizatorul GitHub care a deschis issue-ul.

+

+ +

+

+ +

+

+

+GitHub REST API oferă un endpoint [`Comments`](https://docs.github.com/en/rest/reference/issues#list-issue-comments) care returnează toate comentariile asociate numărului problemei. Să testăm endpointul pentru a vedea ce returnează:

+

+```py

+issue_number = 2792

+url = f"https://api.github.com/repos/huggingface/datasets/issues/{issue_number}/comments"

+response = requests.get(url, headers=headers)

+response.json()

+```

+

+```python out

+[{'url': 'https://api.github.com/repos/huggingface/datasets/issues/comments/897594128',

+ 'html_url': 'https://github.com/huggingface/datasets/pull/2792#issuecomment-897594128',

+ 'issue_url': 'https://api.github.com/repos/huggingface/datasets/issues/2792',

+ 'id': 897594128,

+ 'node_id': 'IC_kwDODunzps41gDMQ',

+ 'user': {'login': 'bhavitvyamalik',

+ 'id': 19718818,

+ 'node_id': 'MDQ6VXNlcjE5NzE4ODE4',

+ 'avatar_url': 'https://avatars.githubusercontent.com/u/19718818?v=4',

+ 'gravatar_id': '',

+ 'url': 'https://api.github.com/users/bhavitvyamalik',

+ 'html_url': 'https://github.com/bhavitvyamalik',

+ 'followers_url': 'https://api.github.com/users/bhavitvyamalik/followers',

+ 'following_url': 'https://api.github.com/users/bhavitvyamalik/following{/other_user}',

+ 'gists_url': 'https://api.github.com/users/bhavitvyamalik/gists{/gist_id}',

+ 'starred_url': 'https://api.github.com/users/bhavitvyamalik/starred{/owner}{/repo}',

+ 'subscriptions_url': 'https://api.github.com/users/bhavitvyamalik/subscriptions',

+ 'organizations_url': 'https://api.github.com/users/bhavitvyamalik/orgs',

+ 'repos_url': 'https://api.github.com/users/bhavitvyamalik/repos',

+ 'events_url': 'https://api.github.com/users/bhavitvyamalik/events{/privacy}',

+ 'received_events_url': 'https://api.github.com/users/bhavitvyamalik/received_events',

+ 'type': 'User',

+ 'site_admin': False},

+ 'created_at': '2021-08-12T12:21:52Z',

+ 'updated_at': '2021-08-12T12:31:17Z',

+ 'author_association': 'CONTRIBUTOR',

+ 'body': "@albertvillanova my tests are failing here:\r\n```\r\ndataset_name = 'gooaq'\r\n\r\n def test_load_dataset(self, dataset_name):\r\n configs = self.dataset_tester.load_all_configs(dataset_name, is_local=True)[:1]\r\n> self.dataset_tester.check_load_dataset(dataset_name, configs, is_local=True, use_local_dummy_data=True)\r\n\r\ntests/test_dataset_common.py:234: \r\n_ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ \r\ntests/test_dataset_common.py:187: in check_load_dataset\r\n self.parent.assertTrue(len(dataset[split]) > 0)\r\nE AssertionError: False is not true\r\n```\r\nWhen I try loading dataset on local machine it works fine. Any suggestions on how can I avoid this error?",

+ 'performed_via_github_app': None}]

+```

+

+Putem vedea că comentariul este stocat în câmpul `body`, așa că putem scrie o funcție simplă care returnează toate comentariile asociate unei probleme prin extragerea conținutului `body` pentru fiecare element în `response.json()`:

+

+```py

+def get_comments(issue_number):

+ url = f"https://api.github.com/repos/huggingface/datasets/issues/{issue_number}/comments"

+ response = requests.get(url, headers=headers)

+ return [r["body"] for r in response.json()]

+

+

+# Testăm dacă funcția lucrează cum ne dorim

+get_comments(2792)

+```

+

+```python out

+["@albertvillanova my tests are failing here:\r\n```\r\ndataset_name = 'gooaq'\r\n\r\n def test_load_dataset(self, dataset_name):\r\n configs = self.dataset_tester.load_all_configs(dataset_name, is_local=True)[:1]\r\n> self.dataset_tester.check_load_dataset(dataset_name, configs, is_local=True, use_local_dummy_data=True)\r\n\r\ntests/test_dataset_common.py:234: \r\n_ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ \r\ntests/test_dataset_common.py:187: in check_load_dataset\r\n self.parent.assertTrue(len(dataset[split]) > 0)\r\nE AssertionError: False is not true\r\n```\r\nWhen I try loading dataset on local machine it works fine. Any suggestions on how can I avoid this error?"]

+```

+

+Arată bine. Acum hai să folosim `Dataset.map()` pentru a adăuga noi coloane `comments` fiecărui issue în datasetul nostru:

+

+```py

+# Depending on your internet connection, this can take a few minutes...

+issues_with_comments_dataset = issues_dataset.map(

+ lambda x: {"comments": get_comments(x["number"])}

+)

+```

+

+Ultimul pas este să facem push datasetului nostru pe Hub. Să vedem cum putem face asta.

+

+## Încărcarea datasetului pe Hugging Face Hub[[uploading-the-dataset-to-the-hugging-face-hub]]

+

+ +

+

+ +

+

+

+2. Citiți [ghidul 🤗 Datasets](https://github.com/huggingface/datasets/blob/master/templates/README_guide.md) despre crearea de dataset cards informative și utilizați-l ca șablon.

+

+Puteți crea fișierul *README.md* direct pe Hub și puteți găsi un template pentru dataset card în repositoriul `lewtun/github-issues`. Un screenshot a dataset card completată este afișată mai jos.

+

+ +

+

+ +

+

+

+ +

+

+ +

+ +

+

+

+## Încărcarea și pregătirea datasetului[[loading-and-preparing-the-dataset]]

+

+Prima lucru pe care trebuie să îl facem este să descărcăm datasetul nostru cu GitHub issues, așa că folosim funcția `load_dataset()` ca de obicei:

+

+```py

+from datasets import load_dataset

+

+issues_dataset = load_dataset("lewtun/github-issues", split="train")

+issues_dataset

+```

+

+```python out

+Dataset({

+ features: ['url', 'repository_url', 'labels_url', 'comments_url', 'events_url', 'html_url', 'id', 'node_id', 'number', 'title', 'user', 'labels', 'state', 'locked', 'assignee', 'assignees', 'milestone', 'comments', 'created_at', 'updated_at', 'closed_at', 'author_association', 'active_lock_reason', 'pull_request', 'body', 'performed_via_github_app', 'is_pull_request'],

+ num_rows: 2855

+})

+```

+

+Aici am specificat splitul default `train` în `load_dataset()`, astfel încât returnează un `Dataset` în loc de `DatasetDict`. Primul lucru care treubuie făcut este să filtrăm pull requesturile, deoarece acestea rareori tind să fie utilizate pentru a răspunde la întrebările utilizatorilor și vor introduce noise în motorul nostru de căutare. Așa cum ar trebuie deja să știți, putem utiliza funcția `Dataset.filter()` pentru a exclude aceste rânduri din datasetul nostru. În timp ce suntem aici, putem să filtrăm și rândurile fără comentari, deoarece acestea nu oferă niciun răspuns la întrebările utilizatorilor:

+

+```py

+issues_dataset = issues_dataset.filter(

+ lambda x: (x["is_pull_request"] == False and len(x["comments"]) > 0)

+)

+issues_dataset

+```

+

+```python out

+Dataset({

+ caracteristici: ['url', 'repository_url', 'labels_url', 'comments_url', 'events_url', 'html_url', 'id', 'node_id', 'number', 'title', 'user', 'labels', 'state', 'locked', 'assignee', 'assignees', 'milestone', 'comments', 'created_at', 'updated_at', 'closed_at', 'author_association', 'active_lock_reason', 'pull_request', 'body', 'performed_via_github_app', 'is_pull_request'],

+ num_rows: 771

+})

+```

+

+Putem vedea că există multe coloane în datasetul nostru, majoritatea dintre care nu sunt necesare pentru a construi motorul nostru de căutare. Din perspectiva căutării, cele mai informative coloane sunt `title`, `body` și `comments`, în timp ce `html_url` ne oferă un link înapoi la problema sursă. Hai să utilizăm funcția `Dataset.remove_columns()` pentru a elimina restul:

+

+```py

+columns = issues_dataset.column_names

+columns_to_keep = ["title", "body", "html_url", "comments"]

+columns_to_remove = set(columns_to_keep).symmetric_difference(columns)

+issues_dataset = issues_dataset.remove_columns(columns_to_remove)

+issues_dataset

+```

+

+```python out

+Dataset({

+ features: ['html_url', 'title', 'comments', 'body'],

+ num_rows: 771

+})

+```

+

+Pentru a crea embeddedurile noastre, vom completa fiecare comentariu cu titlul și body-ul problemei, deoarece aceste câmpuri adesea includ informații contextuale utile. Deoarece coloana noastră `comments` este în prezent o listă de comentarii pentru fiecare issue, trebuie să "explodăm" coloana, astfel încât fiecare rând să fie format dintr-un tuple `(html_url, title, body, comment)`. În Pandas, putem face acest lucru cu funcția [`DataFrame.explode()`](https://pandas.pydata.org/pandas-docs/stable/reference/api/pandas.DataFrame.explode.html), care creează un rând nou pentru fiecare element dintr-o coloană asemănătoare cu o listă, în timp ce copiază toate celelalte valori ale coloanelor. Pentru a vedea acest lucru în acțiune, să trecem la formatul pandas `DataFrame` mai întâi:

+

+```py

+issues_dataset.set_format("pandas")

+df = issues_dataset[:]

+```

+

+Dacă inspectăm primul rând din acest `DataFrame`, putem vedea că există patru comentarii asociate acestei probleme:

+

+```py

+df["comments"][0].tolist()

+```

+

+```python out

+['the bug code locate in :\r\n if data_args.task_name is not None:\r\n # Downloading and loading a dataset from the hub.\r\n datasets = load_dataset("glue", data_args.task_name, cache_dir=model_args.cache_dir)',

+ 'Hi @jinec,\r\n\r\nFrom time to time we get this kind of `ConnectionError` coming from the github.com website: https://raw.githubusercontent.com\r\n\r\nNormally, it should work if you wait a little and then retry.\r\n\r\nCould you please confirm if the problem persists?',

+ 'cannot connect,even by Web browser,please check that there is some problems。',

+ 'I can access https://raw.githubusercontent.com/huggingface/datasets/1.7.0/datasets/glue/glue.py without problem...']

+```

+

+Când facem explode `df`, ne așteptăm să obținem un rând pentru fiecare dintre aceste comentarii. Haideți să verificăm dacă ăsta e cazul:

+

+```py

+comments_df = df.explode("comments", ignore_index=True)

+comments_df.head(4)

+```

+

+| + | html_url | +title | +comments | +body | +

|---|---|---|---|---|

| 0 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +the bug code locate in :\r\n if data_args.task_name is not None... | +Hello,\r\nI am trying to run run_glue.py and it gives me this error... | +

| 1 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +Hi @jinec,\r\n\r\nFrom time to time we get this kind of `ConnectionError` coming from the github.com website: https://raw.githubusercontent.com... | +Hello,\r\nI am trying to run run_glue.py and it gives me this error... | +

| 2 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +cannot connect,even by Web browser,please check that there is some problems。 | +Hello,\r\nI am trying to run run_glue.py and it gives me this error... | +

| 3 | +https://github.com/huggingface/datasets/issues/2787 | +ConnectionError: Couldn't reach https://raw.githubusercontent.com | +I can access https://raw.githubusercontent.com/huggingface/datasets/1.7.0/datasets/glue/glue.py without problem... | +Hello,\r\nI am trying to run run_glue.py and it gives me this error... | +

dataset.shuffle().select(range(50))",

+ explain: "Corect! Așa cum ați văzut în acest capitol, mai întâi faceți shuffle datasetului și apoi selectați exemplele din el.",

+ correct: true

+ },

+ {

+ text: "dataset.select(range(50)).shuffle()",

+ explain: "Acest lucru este incorect -- deși codul va rula, va amesteca doar primele 50 de elemente din setul de date."

+ }

+ ]}

+/>

+

+### 3. Presupunem că aveți un set de date despre animale de companie numit `pets_dataset`, care are o coloană `name` care denotă numele fiecărui animal de companie. Care dintre următoarele abordări v-ar permite să filtrați setul de date pentru toate animalele de companie ale căror nume încep cu litera "L"?

+

+pets_dataset.filter(lambda x['name'].startswith('L'))",

+ explain: "Acest lucru este incorect -- o funcție lambda are forma generală lambda *arguments* : *expression*, deci trebuie să furnizați argumente în acest caz."

+ },

+ {

+ text: "Creați o funcție ca def filter_names(x): return x['name'].startswith('L') și rulați pets_dataset.filter(filter_names).",

+ explain: "Corect! La fel ca și cu Dataset.map(), puteți trece funcții explicite la Dataset.filter(). Acest lucru este util atunci când aveți o logică complexă care nu este potrivită pentru o funcție lambda. Care dintre celelalte soluții ar mai funcționa?",

+ correct: true

+ }

+ ]}

+/>

+

+### 4. Ce este memory mapping?

+

+IterableDataset este un generator, nu un container, deci ar trebui să accesați elementele sale utilizând next(iter(dataset)).",

+ correct: true

+ },

+ {

+ text: "Datasetul allocine nu are o un split train.",

+ explain: "Acest lucru este incorect -- consultați cardul datasetului allocine de pe Hub pentru a vedea ce splituri conține."

+ }

+ ]}

+/>

+

+### 7. Care sunt principalele beneficii ale creării unui dataset card?

+

+

+ +

+ +

+

+

+Cu maparea aceasta, suntem gat a să reproducem(aproape în total) rezultat primului pipeline -- noi putem lua scorul și labelul fiecărui token care nu a fost clasificat ca `O`:

+

+```py

+results = []

+tokens = inputs.tokens()

+

+for idx, pred in enumerate(predictions):

+ label = model.config.id2label[pred]

+ if label != "O":

+ results.append(

+ {"entity": label, "score": probabilities[idx][pred], "word": tokens[idx]}

+ )

+

+print(results)

+```

+

+```python out

+[{'entity': 'I-PER', 'score': 0.9993828, 'index': 4, 'word': 'S'},

+ {'entity': 'I-PER', 'score': 0.99815476, 'index': 5, 'word': '##yl'},

+ {'entity': 'I-PER', 'score': 0.99590725, 'index': 6, 'word': '##va'},

+ {'entity': 'I-PER', 'score': 0.9992327, 'index': 7, 'word': '##in'},

+ {'entity': 'I-ORG', 'score': 0.97389334, 'index': 12, 'word': 'Hu'},

+ {'entity': 'I-ORG', 'score': 0.976115, 'index': 13, 'word': '##gging'},

+ {'entity': 'I-ORG', 'score': 0.98879766, 'index': 14, 'word': 'Face'},

+ {'entity': 'I-LOC', 'score': 0.99321055, 'index': 16, 'word': 'Brooklyn'}]

+```

+

+Acest lucru este foarte similar cu ce am avut mai devreme, cu o excepție: pipelineul de asemenea ne-a oferit informație despre `start` și `end` al fiecărei entități în propoziția originală. Acum e momentul când offset mappingul nostru ne va ajuta. Pentru a obține offseturile, noi trebuie să setăm `return_offsets_mapping=True` când aplicăm tokenizerul pe inputurile noastre:

+

+```py

+inputs_with_offsets = tokenizer(example, return_offsets_mapping=True)

+inputs_with_offsets["offset_mapping"]

+```

+

+```python out

+[(0, 0), (0, 2), (3, 7), (8, 10), (11, 12), (12, 14), (14, 16), (16, 18), (19, 22), (23, 24), (25, 29), (30, 32),

+ (33, 35), (35, 40), (41, 45), (46, 48), (49, 57), (57, 58), (0, 0)]

+```

+

+Fiecare tuple este spanul de text care corespunde fiecărui token, unde `(0, 0)` este rezervat pentru tokenii speciali. Noi am văzut înainte că tokenul la indexul 5 este `##yl`, care are aici `(12, 14)` ca offsets. Dacă luăm sliceul corespunzător în exemplul nostru:

+

+```py

+example[12:14]

+```

+

+noi obținem spanul propriu de text fără `##`:

+

+```python out

+yl

+```

+

+Folosind aceasta, putem acum completa rezultatele anterioare:

+

+

+```py

+results = []

+inputs_with_offsets = tokenizer(example, return_offsets_mapping=True)

+tokens = inputs_with_offsets.tokens()

+offsets = inputs_with_offsets["offset_mapping"]

+

+for idx, pred in enumerate(predictions):

+ label = model.config.id2label[pred]

+ if label != "O":

+ start, end = offsets[idx]

+ results.append(

+ {

+ "entity": label,

+ "score": probabilities[idx][pred],

+ "word": tokens[idx],

+ "start": start,

+ "end": end,

+ }

+ )

+

+print(results)

+```

+

+```python out

+[{'entity': 'I-PER', 'score': 0.9993828, 'index': 4, 'word': 'S', 'start': 11, 'end': 12},

+ {'entity': 'I-PER', 'score': 0.99815476, 'index': 5, 'word': '##yl', 'start': 12, 'end': 14},

+ {'entity': 'I-PER', 'score': 0.99590725, 'index': 6, 'word': '##va', 'start': 14, 'end': 16},

+ {'entity': 'I-PER', 'score': 0.9992327, 'index': 7, 'word': '##in', 'start': 16, 'end': 18},

+ {'entity': 'I-ORG', 'score': 0.97389334, 'index': 12, 'word': 'Hu', 'start': 33, 'end': 35},

+ {'entity': 'I-ORG', 'score': 0.976115, 'index': 13, 'word': '##gging', 'start': 35, 'end': 40},

+ {'entity': 'I-ORG', 'score': 0.98879766, 'index': 14, 'word': 'Face', 'start': 41, 'end': 45},

+ {'entity': 'I-LOC', 'score': 0.99321055, 'index': 16, 'word': 'Brooklyn', 'start': 49, 'end': 57}]

+```

+

+Acest răspuns e același răspuns pe care l-am primit de la primul pipeline:

+

+### Gruparea entităților[[grouping-entities]]

+

+Utilizarea offseturilor pentru a determina cheile de start și de sfârșit pentru fiecare entitate este util, dar această informație nu este strict necesară. Când dorim să grupăm entitățile împreună, totuși, offseturile ne vor salva o mulțime de messy code. De exemplu, dacă am dori să grupăm împreună tokenii `Hu`, `##gging` și `Face`, am putea crea reguli speciale care să spună că primele două ar trebui să fie atașate și să înlăturăm `##`, iar `Face` ar trebui adăugat cu un spațiu, deoarece nu începe cu `##` -- dar acest lucru ar funcționa doar pentru acest tip particular de tokenizer. Ar trebui să scriem un alt set de reguli pentru un tokenizer SentencePiece sau unul Byte-Pair-Encoding (discutat mai târziu în acest capitol).

+

+Cu offseturile, tot acel cod custom dispare: pur și simplu putem lua spanul din textul original care începe cu primul token și se termină cu ultimul token. Deci, în cazul tokenurilor `Hu`, `##gging` și `Face`, ar trebui să începem la caracterul 33 (începutul lui `Hu`) și să ne oprim înainte de caracterul 45 (sfârșitul lui `Face`):

+

+```py

+example[33:45]

+```

+

+```python out

+Hugging Face

+```

+

+Pentru a scrie codul care post-procesează predicțiile în timp ce grupăm entitățile, vom grupa entitățile care sunt consecutive și labeled cu `I-XXX`, cu excepția primeia, care poate fi labeled ca `B-XXX` sau `I-XXX` (decidem să oprim gruparea unei entități atunci când întâlnim un `O`, un nou tip de entitate, sau un `B-XXX` care ne spune că o entitate de același tip începe):

+

+```py

+import numpy as np

+

+results = []

+inputs_with_offsets = tokenizer(example, return_offsets_mapping=True)

+tokens = inputs_with_offsets.tokens()

+offsets = inputs_with_offsets["offset_mapping"]

+

+idx = 0

+while idx < len(predictions):

+ pred = predictions[idx]

+ label = model.config.id2label[pred]

+ if label != "O":

+ # Remove the B- or I-

+ label = label[2:]

+ start, _ = offsets[idx]

+

+ # Grab all the tokens labeled with I-label

+ all_scores = []

+ while (

+ idx < len(predictions)

+ and model.config.id2label[predictions[idx]] == f"I-{label}"

+ ):

+ all_scores.append(probabilities[idx][pred])

+ _, end = offsets[idx]

+ idx += 1

+

+ # The score is the mean of all the scores of the tokens in that grouped entity

+ score = np.mean(all_scores).item()

+ word = example[start:end]

+ results.append(

+ {

+ "entity_group": label,

+ "score": score,

+ "word": word,

+ "start": start,

+ "end": end,

+ }

+ )

+ idx += 1

+

+print(results)

+```

+

+Și obținem aceleași răspuns ca de la pipelineul secundar!

+

+```python out

+[{'entity_group': 'PER', 'score': 0.9981694, 'word': 'Sylvain', 'start': 11, 'end': 18},

+ {'entity_group': 'ORG', 'score': 0.97960204, 'word': 'Hugging Face', 'start': 33, 'end': 45},

+ {'entity_group': 'LOC', 'score': 0.99321055, 'word': 'Brooklyn', 'start': 49, 'end': 57}]

+```

+

+Alt exemplu de sarcină unde offseturile sunt extrem de useful pentru răspunderea la întrebări. Scufundându-ne în pipelineuri, un lucru pe care îl vom face în următoarea secțiune, ne vom premite să ne uităm peste o caracteristică a tokenizerului în librăria 🤗 Transformers: vom avea de-a face cu overflowing tokens când truncăm un input de o anumită lungime.

+

diff --git a/chapters/rum/chapter6/3b.mdx b/chapters/rum/chapter6/3b.mdx

new file mode 100644

index 000000000..0a7997708

--- /dev/null

+++ b/chapters/rum/chapter6/3b.mdx

@@ -0,0 +1,643 @@

+

+ +

+ +

+

+

+Modelele create pentru răspunderea la întrebări funcționează puțin diferit de modelele pe care le-am văzut până acum. Folosind imaginea de mai sus ca exemplu, modelul a fost antrenat pentru a prezice indicele tokenului cu care începe răspunsului (aici 21) și indicele simbolului la care se termină răspunsul (aici 24). Acesta este motivul pentru care modelele respective nu returnează un singur tensor de logits, ci două: unul pentru logits-ul corespunzători tokenului cu care începe răspunsului și unul pentru logits-ul corespunzător tokenului de sfârșit al răspunsului. Deoarece în acest caz avem un singur input care conține 66 de token-uri, obținem:

+

+```py

+start_logits = outputs.start_logits

+end_logits = outputs.end_logits

+print(start_logits.shape, end_logits.shape)

+```

+

+{#if fw === 'pt'}

+

+```python out

+torch.Size([1, 66]) torch.Size([1, 66])

+```

+

+{:else}

+

+```python out

+(1, 66) (1, 66)

+```

+

+{/if}

+

+Pentru a converti acești logits în probabilități, vom aplica o funcție softmax - dar înainte de aceasta, trebuie să ne asigurăm că mascăm indicii care nu fac parte din context. Inputul nostru este `[CLS] întrebare [SEP] context [SEP]`, deci trebuie să mascăm token-urile întrebării, precum și tokenul `[SEP]`. Cu toate acestea, vom păstra simbolul `[CLS]`, deoarece unele modele îl folosesc pentru a indica faptul că răspunsul nu se află în context.

+

+Deoarece vom aplica ulterior un softmax, trebuie doar să înlocuim logiturile pe care dorim să le mascăm cu un număr negativ mare. Aici, folosim `-10000`:

+

+{#if fw === 'pt'}

+

+```py

+import torch

+

+sequence_ids = inputs.sequence_ids()

+# Mask everything apart from the tokens of the context

+mask = [i != 1 for i in sequence_ids]

+# Unmask the [CLS] token

+mask[0] = False

+mask = torch.tensor(mask)[None]

+

+start_logits[mask] = -10000

+end_logits[mask] = -10000

+```

+

+{:else}

+

+```py

+import tensorflow as tf

+

+sequence_ids = inputs.sequence_ids()

+# Mask everything apart from the tokens of the context

+mask = [i != 1 for i in sequence_ids]

+# Unmask the [CLS] token

+mask[0] = False

+mask = tf.constant(mask)[None]

+

+start_logits = tf.where(mask, -10000, start_logits)

+end_logits = tf.where(mask, -10000, end_logits)

+```

+

+{/if}

+

+Acum că am mascat în mod corespunzător logiturile corespunzătoare pozițiilor pe care nu dorim să le prezicem, putem aplica softmax:

+

+{#if fw === 'pt'}

+

+```py

+start_probabilities = torch.nn.functional.softmax(start_logits, dim=-1)[0]

+end_probabilities = torch.nn.functional.softmax(end_logits, dim=-1)[0]

+```

+

+{:else}

+

+```py

+start_probabilities = tf.math.softmax(start_logits, axis=-1)[0].numpy()

+end_probabilities = tf.math.softmax(end_logits, axis=-1)[0].numpy()

+```

+

+{/if}

+

+La acest stadiu, am putea lua argmax al probabilităților de început și de sfârșit - dar am putea ajunge la un indice de început care este mai mare decât indicele de sfârșit, deci trebuie să luăm câteva precauții suplimentare. Vom calcula probabilitățile fiecărui `start_index` și `end_index` posibil în cazul în care `start_index <= end_index`, apoi vom lua un tuple `(start_index, end_index)` cu cea mai mare probabilitate.

+

+Presupunând că evenimentele "The answer starts at `start_index`" și "The answer ends at `end_index`" sunt independente, probabilitatea ca răspunsul să înceapă la `start_index` și să se termine la `end_index` este:

+

+$$\mathrm{start\_probabilities}[\mathrm{start\_index}] \times \mathrm{end\_probabilities}[\mathrm{end\_index}]$$

+

+Deci, pentru a calcula toate scorurile, trebuie doar să calculăm toate produsele \\(\mathrm{start\_probabilities}[\mathrm{start\_index}] \times \mathrm{end\_probabilities}[\mathrm{end\_index}]\\) unde `start_index <= end_index`.

+

+Mai întâi hai să calculăm toate produsele posibile:

+

+```py

+scores = start_probabilities[:, None] * end_probabilities[None, :]

+```

+

+{#if fw === 'pt'}

+

+Apoi vom masca valorile în care `start_index > end_index` prin stabilirea lor la `0` (celelalte probabilități sunt toate numere pozitive). Funcția `torch.triu()` returnează partea triunghiulară superioară a tensorului 2D trecut ca argument, deci va face această mascare pentru noi:

+

+```py

+scores = torch.triu(score)

+```

+

+{:else}

+

+Apoi vom masca valorile în care `start_index > end_index` prin stabilirea lor la `0` (celelalte probabilități sunt toate numere pozitive). Funcția `np.triu()` returnează partea triunghiulară superioară a tensorului 2D trecut ca argument, deci va face această mascare pentru noi:

+

+```py

+import numpy as np

+

+scores = np.triu(scores)

+```

+

+{/if}

+

+Acum trebuie doar să obținem indicele maximului. Deoarece PyTorch va returna indicele în tensorul aplatizat, trebuie să folosim operațiile floor division `//` și modulusul `%` pentru a obține `start_index` și `end_index`:

+

+```py

+max_index = scores.argmax().item()

+start_index = max_index // scores.shape[1]

+end_index = max_index % scores.shape[1]

+print(scores[start_index, end_index])

+```

+

+Nu am terminat încă, dar cel puțin avem deja scorul corect pentru răspuns (puteți verifica acest lucru comparându-l cu primul rezultat din secțiunea anterioară):

+

+```python out

+0.97773

+```

+

+

+ +

+ +

+

+

+Înainte de a împărți un text în subtokens (în conformitate cu modelul său), tokenizerul efectuează doi pași: _normalization__ și _pre-tokenization_.

+

+## Normalization[[normalization]]

+

+

+ +

+ +

+

+

+Biblioteca 🤗 Tokenizers a fost construită pentru a oferi mai multe opțiuni pentru fiecare dintre acești pași, pe care le puteți amesteca și combina împreună. În această secțiune vom vedea cum putem construi un tokenizer de la zero, spre deosebire de antrenarea unui tokenizer nou dintr-unul vechi, așa cum am făcut în [secțiunea 2](/course/chapter6/2). Veți putea apoi să construiți orice fel de tokenizer la care vă puteți gândi!

+

+`` și '' cu " și orice secvență de două sau mai multe spații cu un singur spațiu, precum și ștergerea accentelor în textele ce trebuie tokenizate.

+

+Pre-tokenizerul care trebuie utilizat pentru orice tokenizer SentencePiece este `Metaspace`:

+

+```python

+tokenizer.pre_tokenizer = pre_tokenizers.Metaspace()

+```

+

+Putem arunca o privire la pre-tokenizarea unui exemplu de text ca mai înainte:

+

+```python

+tokenizer.pre_tokenizer.pre_tokenize_str("Let's test the pre-tokenizer!")

+```

+

+```python out

+[("▁Let's", (0, 5)), ('▁test', (5, 10)), ('▁the', (10, 14)), ('▁pre-tokenizer!', (14, 29))]

+```

+

+Urmează modelul, care are nevoie de antrenare. XLNet are destul de mulți tokeni speciali:

+

+```python

+special_tokens = [" +

+ +

+

+Puteți găsi modelul pe care îl vom antrena și încărca în Hub și puteți verifica de două ori predicțiile sale [aici](https://huggingface.co/huggingface-course/bert-finetuned-ner?text=My+name+is+Sylvain+and+I+work+at+Hugging+Face+in+Brooklyn).

+

+## Pregătirea datelor[[preparing-the-data]]

+

+În primul rând, avem nevoie de un dataset adecvat pentru clasificarea simbolurilor. În această secțiune vom utiliza [datasetul CoNLL-2003] (https://huggingface.co/datasets/conll2003), care conține știri de la Reuters.

+

+

+

+

+Puteți găsi modelul pe care îl vom antrena și încărca în Hub și puteți verifica de două ori predicțiile sale [aici](https://huggingface.co/huggingface-course/bert-finetuned-ner?text=My+name+is+Sylvain+and+I+work+at+Hugging+Face+in+Brooklyn).

+

+## Pregătirea datelor[[preparing-the-data]]

+

+În primul rând, avem nevoie de un dataset adecvat pentru clasificarea simbolurilor. În această secțiune vom utiliza [datasetul CoNLL-2003] (https://huggingface.co/datasets/conll2003), care conține știri de la Reuters.

+

+

+ +

+ +

+

+

+Până la sfârșitul acestei secțiuni, veți avea un [model de limbaj mascat](https://huggingface.co/huggingface-course/distilbert-base-uncased-finetuned-imdb?text=This+is+a+great+%5BMASK%5D.) pe Hub, care poate completa automat propoziții, după cum se poate vedea mai jos:

+

+

+

+Hai să începem!

+

+

+ +

+

+

+Deși modelele din familia BERT și RoBERTa sunt cele mai descărcate, vom utiliza un model numit [DistilBERT](https://huggingface.co/distilbert-base-uncased)

+care poate fi antrenat mult mai rapid, cu o pierdere mică sau nulă a performanței în aval. Acest model a fost antrenat folosind o tehnică specială numită [_knowledge distillation_](https://en.wikipedia.org/wiki/Knowledge_distillation), în care un "model profesor" mare, precum BERT, este folosit pentru a ghida antrenarea unui "model elev" care are mult mai puțini parametrii. O explicație a detaliilor privind distilarea cunoștințelor ne-ar duce prea departe în această secțiune, dar dacă ești interesat, poți citi totul despre aceasta în [_Natural Language Processing with Transformers_](https://www.oreilly.com/library/view/natural-language-processing/9781098136789/) (cunoscut sub numele colocvial de Transformers textbooks).

+

+{#if fw === 'pt'}

+

+Să continuăm și să descărcăm modelul DistilBERT folosind clasa `AutoModelForMaskedLM`:

+

+```python

+from transformers import AutoModelForMaskedLM

+

+model_checkpoint = "distilbert-base-uncased"

+model = AutoModelForMaskedLM.from_pretrained(model_checkpoint)

+```

+

+Putem vedea câți parametri are acest model prin apelarea metodei `num_parameters()`:

+

+```python

+distilbert_num_parameters = model.num_parameters() / 1_000_000

+print(f"'>>> DistilBERT number of parameters: {round(distilbert_num_parameters)}M'")

+print(f"'>>> BERT number of parameters: 110M'")

+```

+

+```python out

+'>>> DistilBERT number of parameters: 67M'

+'>>> BERT number of parameters: 110M'

+```

+

+{:else}

+

+Să continuăm și să descărcăm modelul DistilBERT folosind clasa `TFAutoModelForMaskedLM`:

+

+```python

+from transformers import TFAutoModelForMaskedLM

+

+model_checkpoint = "distilbert-base-uncased"

+model = TFAutoModelForMaskedLM.from_pretrained(model_checkpoint)

+```

+

+Putem vedea câți parametri are acest model prin apelarea metodei `summary()`:

+

+```python

+model.summary()

+```

+

+```python out

+Model: "tf_distil_bert_for_masked_lm"

+_________________________________________________________________

+Layer (type) Output Shape Param #

+=================================================================

+distilbert (TFDistilBertMain multiple 66362880

+_________________________________________________________________

+vocab_transform (Dense) multiple 590592

+_________________________________________________________________

+vocab_layer_norm (LayerNorma multiple 1536

+_________________________________________________________________

+vocab_projector (TFDistilBer multiple 23866170

+=================================================================

+Total params: 66,985,530

+Trainable params: 66,985,530

+Non-trainable params: 0

+_________________________________________________________________

+```

+

+{/if}

+

+Cu aproximativ 67 de milioane de parametri, DistilBERT este de aproximativ două ori mai mic decât modelul de bază BERT, ceea ce se traduce aproximativ printr-o creștere de două ori a vitezei de antrenare - super! Să vedem acum ce tipuri de tokeni prezice acest model ca fiind cele mai probabile completări ale unui mic sample de text:

+

+```python

+text = "This is a great [MASK]."

+```

+

+Ca oameni, ne putem imagina multe posibilități pentru tokenul `[MASK]`, cum ar fi "day", "ride" sau "painting". Pentru modelele preantrenate, predicțiile depind de corpusul pe care modelul a fost antrenat, deoarece acesta învață să detecteze tiparele statistice prezente în date. La fel ca BERT, DistilBERT a fost preantrenat pe dataseturile [English Wikipedia](https://huggingface.co/datasets/wikipedia) și [BookCorpus](https://huggingface.co/datasets/bookcorpus), astfel încât ne așteptăm ca predicțiile pentru `[MASK]` să reflecte aceste domenii. Pentru a prezice masca, avem nevoie de tokenizerul DistilBERT pentru a produce inputurile pentru model, deci hai să-l descărcăm și pe acesta din Hub:

+

+```python

+from transformers import AutoTokenizer

+

+tokenizer = AutoTokenizer.from_pretrained(model_checkpoint)

+```

+

+Cu un tokenizer și un model, putem acum să transmitem exemplul nostru de text modelului, să extragem logiturile și să tipărim primii 5 candidați:

+

+{#if fw === 'pt'}

+

+```python

+import torch

+

+inputs = tokenizer(text, return_tensors="pt")

+token_logits = model(**inputs).logits

+# Find the location of [MASK] and extract its logits

+mask_token_index = torch.where(inputs["input_ids"] == tokenizer.mask_token_id)[1]

+mask_token_logits = token_logits[0, mask_token_index, :]

+# Pick the [MASK] candidates with the highest logits

+top_5_tokens = torch.topk(mask_token_logits, 5, dim=1).indices[0].tolist()

+

+for token in top_5_tokens:

+ print(f"'>>> {text.replace(tokenizer.mask_token, tokenizer.decode([token]))}'")

+```

+

+{:else}

+

+```python

+import numpy as np

+import tensorflow as tf

+

+inputs = tokenizer(text, return_tensors="np")

+token_logits = model(**inputs).logits

+# Find the location of [MASK] and extract its logits

+mask_token_index = np.argwhere(inputs["input_ids"] == tokenizer.mask_token_id)[0, 1]

+mask_token_logits = token_logits[0, mask_token_index, :]

+# Pick the [MASK] candidates with the highest logits

+# We negate the array before argsort to get the largest, not the smallest, logits

+top_5_tokens = np.argsort(-mask_token_logits)[:5].tolist()

+

+for token in top_5_tokens:

+ print(f">>> {text.replace(tokenizer.mask_token, tokenizer.decode([token]))}")

+```

+

+{/if}

+

+```python out

+'>>> This is a great deal.'

+'>>> This is a great success.'

+'>>> This is a great adventure.'

+'>>> This is a great idea.'

+'>>> This is a great feat.'

+```

+Putem vedea din rezultate că predicțiile modelului se referă la termeni din viața de zi cu zi, ceea ce poate că nu este surprinzător având în vedere fundamentul Wikipedia în limba engleză. Să vedem cum putem schimba acest domeniu în ceva puțin mai nișat - recenzii de filme foarte polarizate!

+

+

+## Datasetul[[the-dataset]]

+

+Pentru a prezenta adaptarea la domeniu, vom utiliza faimosul [Large Movie Review Dataset] (https://huggingface.co/datasets/imdb) (sau IMDb pe scurt), care este un corpus de recenzii de filme care este adesea utilizat pentru a evalua modelele de analiză a sentimentelor. Prin fine-tuningul aplicat asupra DistilBERT pe acest corpus, ne așteptăm ca modelul de limbaj să își adapteze vocabularul de la datele factuale din Wikipedia pe care a fost antrenat în prealabil la elementele mai subiective ale recenziilor de film. Putem obține datele din Hugging Face Hub cu funcția `load_dataset()` din 🤗 Datasets:

+

+```python

+from datasets import load_dataset

+

+imdb_dataset = load_dataset("imdb")

+imdb_dataset

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['text', 'label'],

+ num_rows: 25000

+ })

+ test: Dataset({

+ features: ['text', 'label'],

+ num_rows: 25000

+ })

+ unsupervised: Dataset({

+ features: ['text', 'label'],

+ num_rows: 50000

+ })

+})

+```

+

+Putem vedea că segmentele `train` și `test` conțin fiecare 25.000 de recenzii, în timp ce există un segment fără label numită `unsupervised` care conține 50.000 de recenzii. Să aruncăm o privire la câteva sampleuri pentru a ne face o idee despre tipul de text cu care avem de-a face. Așa cum am făcut în capitolele anterioare ale cursului, vom combina funcțiile `Dataset.shuffle()` și `Dataset.select()` pentru a crea un sample aleatoriu:

+

+```python

+sample = imdb_dataset["train"].shuffle(seed=42).select(range(3))

+

+for row in sample:

+ print(f"\n'>>> Review: {row['text']}'")

+ print(f"'>>> Label: {row['label']}'")

+```

+

+```python out

+

+'>>> Review: This is your typical Priyadarshan movie--a bunch of loony characters out on some silly mission. His signature climax has the entire cast of the film coming together and fighting each other in some crazy moshpit over hidden money. Whether it is a winning lottery ticket in Malamaal Weekly, black money in Hera Pheri, "kodokoo" in Phir Hera Pheri, etc., etc., the director is becoming ridiculously predictable. Don\'t get me wrong; as clichéd and preposterous his movies may be, I usually end up enjoying the comedy. However, in most his previous movies there has actually been some good humor, (Hungama and Hera Pheri being noteworthy ones). Now, the hilarity of his films is fading as he is using the same formula over and over again. +

+Songs are good. Tanushree Datta looks awesome. Rajpal Yadav is irritating, and Tusshar is not a whole lot better. Kunal Khemu is OK, and Sharman Joshi is the best.' +'>>> Label: 0' + +'>>> Review: Okay, the story makes no sense, the characters lack any dimensionally, the best dialogue is ad-libs about the low quality of movie, the cinematography is dismal, and only editing saves a bit of the muddle, but Sam" Peckinpah directed the film. Somehow, his direction is not enough. For those who appreciate Peckinpah and his great work, this movie is a disappointment. Even a great cast cannot redeem the time the viewer wastes with this minimal effort.

The proper response to the movie is the contempt that the director San Peckinpah, James Caan, Robert Duvall, Burt Young, Bo Hopkins, Arthur Hill, and even Gig Young bring to their work. Watch the great Peckinpah films. Skip this mess.' +'>>> Label: 0' + +'>>> Review: I saw this movie at the theaters when I was about 6 or 7 years old. I loved it then, and have recently come to own a VHS version.

My 4 and 6 year old children love this movie and have been asking again and again to watch it.

I have enjoyed watching it again too. Though I have to admit it is not as good on a little TV.

I do not have older children so I do not know what they would think of it.

The songs are very cute. My daughter keeps singing them over and over.

Hope this helps.' +'>>> Label: 1' +``` + +Da, acestea sunt cu siguranță recenzii de film și, dacă sunteți suficient de bătrâni, ați putea chiar înțelege comentariul din ultima recenzie despre deținerea unei versiuni VHS 😜! Deși nu vom avea nevoie de labeluri pentru modelarea limbajului, putem vedea deja că un `0` denotă o recenzie negativă, în timp ce un `1` corespunde uneia pozitive. + +

+

+ +

+

+Ca și în secțiunile anterioare, puteți găsi modelul pe care îl vom antrena și încărca în Hub utilizând codul de mai jos și puteți verifica predicțiile acestuia [aici](https://huggingface.co/huggingface-course/marian-finetuned-kde4-en-to-fr?text=This+plugin+allows+you+to+automatically+translate+web+pages+between+several+languages.).

+

+## Pregătirea datelor[[preparing-the-data]]

+

+Pentru a face fine-tune sau a antrena un model de traducere de la zero, vom avea nevoie de un dataset adecvat pentru această sarcină. După cum am menționat anterior, vom utiliza [datasetul KDE4](https://huggingface.co/datasets/kde4) în această secțiune, dar puteți adapta codul pentru a utiliza propriile date destul de ușor, atâta timp cât aveți perechi de propoziții în cele două limbi din și în care doriți să traduceți. Consultați [Capitolul 5](/course/chapter5) dacă aveți nevoie de o reamintire a modului de încărcare a datelor personalizate într-un `Dataset`.

+

+### Datasetul KDE4[[the-kde4-dataset]]

+

+Ca de obicei, descărcăm datasetul nostru folosind funcția `load_dataset()`:

+

+```py

+from datasets import load_dataset

+

+raw_datasets = load_dataset("kde4", lang1="en", lang2="fr")

+```

+

+Dacă doriți să lucrați cu o pereche de limbi diferită, le puteți specifica prin codurile lor. Un total de 92 de limbi sunt disponibile pentru acest dataset; le puteți vedea pe toate prin extinderea labelurilor de limbă pe [dataset cardul acesteia](https://huggingface.co/datasets/kde4).

+

+

+

+

+Ca și în secțiunile anterioare, puteți găsi modelul pe care îl vom antrena și încărca în Hub utilizând codul de mai jos și puteți verifica predicțiile acestuia [aici](https://huggingface.co/huggingface-course/marian-finetuned-kde4-en-to-fr?text=This+plugin+allows+you+to+automatically+translate+web+pages+between+several+languages.).

+

+## Pregătirea datelor[[preparing-the-data]]

+

+Pentru a face fine-tune sau a antrena un model de traducere de la zero, vom avea nevoie de un dataset adecvat pentru această sarcină. După cum am menționat anterior, vom utiliza [datasetul KDE4](https://huggingface.co/datasets/kde4) în această secțiune, dar puteți adapta codul pentru a utiliza propriile date destul de ușor, atâta timp cât aveți perechi de propoziții în cele două limbi din și în care doriți să traduceți. Consultați [Capitolul 5](/course/chapter5) dacă aveți nevoie de o reamintire a modului de încărcare a datelor personalizate într-un `Dataset`.

+

+### Datasetul KDE4[[the-kde4-dataset]]

+

+Ca de obicei, descărcăm datasetul nostru folosind funcția `load_dataset()`:

+

+```py

+from datasets import load_dataset

+

+raw_datasets = load_dataset("kde4", lang1="en", lang2="fr")

+```

+

+Dacă doriți să lucrați cu o pereche de limbi diferită, le puteți specifica prin codurile lor. Un total de 92 de limbi sunt disponibile pentru acest dataset; le puteți vedea pe toate prin extinderea labelurilor de limbă pe [dataset cardul acesteia](https://huggingface.co/datasets/kde4).

+

+ +

+Să aruncăm o privire la dataset:

+

+```py

+raw_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 210173

+ })

+})

+```

+

+Avem 210 173 de perechi de propoziții, dar într-o singură împărțire, deci va trebui să ne creăm propriul set de validare. Așa cum am văzut în [Capitolul 5](/course/chapter5), un `Dataset` are o metodă `train_test_split()` care ne poate ajuta. Vom furniza un seed pentru reproductibilitate:

+

+```py

+split_datasets = raw_datasets["train"].train_test_split(train_size=0.9, seed=20)

+split_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 189155

+ })

+ test: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 21018

+ })

+})

+```

+

+Putem redenumi cheia `"test"` în `"validation"` astfel:

+

+```py

+split_datasets["validation"] = split_datasets.pop("test")

+```

+

+Acum să aruncăm o privire la un element al datasetului:

+

+```py

+split_datasets["train"][1]["translation"]

+```

+

+```python out

+{'en': 'Default to expanded threads',

+ 'fr': 'Par défaut, développer les fils de discussion'}

+```

+

+Obținem un dicționar cu două propoziții în perechea de limbi solicitate. O particularitate a acestui dataset plin de termeni tehnici din domeniul informaticii este că toate sunt traduse integral în franceză. Cu toate acestea, inginerii francezi lasă majoritatea cuvintelor specifice informaticii în engleză atunci când vorbesc. Aici, de exemplu, cuvântul "threads" ar putea foarte bine să apară într-o propoziție în limba franceză, în special într-o conversație tehnică; dar în acest dataset a fost tradus în "fils de discussion". Modelul preantrenat pe care îl folosim, care a fost preantrenat pe un corpus mai mare de propoziții în franceză și engleză, alege opțiunea mai ușoară de a lăsa cuvântul așa cum este:

+

+```py

+from transformers import pipeline

+

+model_checkpoint = "Helsinki-NLP/opus-mt-en-fr"

+translator = pipeline("translation", model=model_checkpoint)

+translator("Default to expanded threads")

+```

+

+```python out

+[{'translation_text': 'Par défaut pour les threads élargis'}]

+```

+

+Un alt exemplu al acestui comportament poate fi văzut cu cuvântul "plugin", care nu este oficial un cuvânt francez, dar pe care majoritatea vorbitorilor nativi îl vor înțelege și nu se vor obosi să îl traducă.

+În datasetul KDE4, acest cuvânt a fost tradus în franceză în termenul puțin mai oficial "module d'extension":

+

+```py

+split_datasets["train"][172]["translation"]

+```

+

+```python out

+{'en': 'Unable to import %1 using the OFX importer plugin. This file is not the correct format.',

+ 'fr': "Impossible d'importer %1 en utilisant le module d'extension d'importation OFX. Ce fichier n'a pas un format correct."}

+```

+

+Modelul nostru preantrenat, cu toate acestea, rămâne la cuvântul englez compact și familiar:

+

+```py

+translator(

+ "Unable to import %1 using the OFX importer plugin. This file is not the correct format."

+)

+```

+

+```python out

+[{'translation_text': "Impossible d'importer %1 en utilisant le plugin d'importateur OFX. Ce fichier n'est pas le bon format."}]

+```

+

+Va fi interesant de văzut dacă modelul nostru fine-tuned reține aceste particularități ale datasetului(spoiler alert: va reține).

+

+

+

+Să aruncăm o privire la dataset:

+

+```py

+raw_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 210173

+ })

+})

+```

+

+Avem 210 173 de perechi de propoziții, dar într-o singură împărțire, deci va trebui să ne creăm propriul set de validare. Așa cum am văzut în [Capitolul 5](/course/chapter5), un `Dataset` are o metodă `train_test_split()` care ne poate ajuta. Vom furniza un seed pentru reproductibilitate:

+

+```py

+split_datasets = raw_datasets["train"].train_test_split(train_size=0.9, seed=20)

+split_datasets

+```

+

+```python out

+DatasetDict({

+ train: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 189155

+ })

+ test: Dataset({

+ features: ['id', 'translation'],

+ num_rows: 21018

+ })

+})

+```

+

+Putem redenumi cheia `"test"` în `"validation"` astfel:

+

+```py

+split_datasets["validation"] = split_datasets.pop("test")

+```

+

+Acum să aruncăm o privire la un element al datasetului:

+

+```py

+split_datasets["train"][1]["translation"]

+```

+

+```python out

+{'en': 'Default to expanded threads',

+ 'fr': 'Par défaut, développer les fils de discussion'}

+```

+

+Obținem un dicționar cu două propoziții în perechea de limbi solicitate. O particularitate a acestui dataset plin de termeni tehnici din domeniul informaticii este că toate sunt traduse integral în franceză. Cu toate acestea, inginerii francezi lasă majoritatea cuvintelor specifice informaticii în engleză atunci când vorbesc. Aici, de exemplu, cuvântul "threads" ar putea foarte bine să apară într-o propoziție în limba franceză, în special într-o conversație tehnică; dar în acest dataset a fost tradus în "fils de discussion". Modelul preantrenat pe care îl folosim, care a fost preantrenat pe un corpus mai mare de propoziții în franceză și engleză, alege opțiunea mai ușoară de a lăsa cuvântul așa cum este:

+

+```py

+from transformers import pipeline

+

+model_checkpoint = "Helsinki-NLP/opus-mt-en-fr"

+translator = pipeline("translation", model=model_checkpoint)

+translator("Default to expanded threads")

+```

+

+```python out

+[{'translation_text': 'Par défaut pour les threads élargis'}]

+```

+

+Un alt exemplu al acestui comportament poate fi văzut cu cuvântul "plugin", care nu este oficial un cuvânt francez, dar pe care majoritatea vorbitorilor nativi îl vor înțelege și nu se vor obosi să îl traducă.

+În datasetul KDE4, acest cuvânt a fost tradus în franceză în termenul puțin mai oficial "module d'extension":

+

+```py

+split_datasets["train"][172]["translation"]

+```

+

+```python out

+{'en': 'Unable to import %1 using the OFX importer plugin. This file is not the correct format.',

+ 'fr': "Impossible d'importer %1 en utilisant le module d'extension d'importation OFX. Ce fichier n'a pas un format correct."}

+```

+

+Modelul nostru preantrenat, cu toate acestea, rămâne la cuvântul englez compact și familiar:

+

+```py

+translator(

+ "Unable to import %1 using the OFX importer plugin. This file is not the correct format."

+)

+```

+

+```python out

+[{'translation_text': "Impossible d'importer %1 en utilisant le plugin d'importateur OFX. Ce fichier n'est pas le bon format."}]

+```

+

+Va fi interesant de văzut dacă modelul nostru fine-tuned reține aceste particularități ale datasetului(spoiler alert: va reține).

+

+

+ +

+ +

+

+

+Pentru a rezolva acest lucru, vom filtra exemplele cu titluri foarte scurte, astfel încât modelul nostru să poată produce rezumate mai interesante. Deoarece avem de-a face cu texte în engleză și spaniolă, putem folosi rough heuristic pentru a face split titlurilor pe baza spațiului alb și apoi să folosim metoda noastră de încredere `Dataset.filter()` după cum urmează:

+

+```python

+books_dataset = books_dataset.filter(lambda x: len(x["review_title"].split()) > 2)

+```

+

+Now that we've prepared our corpus, let's take a look at a few possible Transformer models that one might fine-tune on it!

+

+## Modele pentru sumarizarea textului[[models-for-text-summarization]]

+

+Dacă vă gândiți bine, rezumarea textului este o sarcină similară cu machine translation: avem un corp de text, cum ar fi o recenzie, pe care am dori să o "traducem" într-o versiune mai scurtă care să capteze caracteristicile principale ale datelor de intrare. În consecință, majoritatea modelelor Transformer pentru rezumare adoptă arhitectura codificator-decodificator pe care am întâlnit-o pentru prima dată în [Capitolul 1](/course/chapter1), deși există unele excepții, cum ar fi familia de modele GPT, care poate fi, de asemenea, utilizată pentru rezumare în few-shot settings. Tabelul de mai jos enumeră câteva modele preantrenate populare care pot fi ajustate pentru sumarizare.

+

+| Transformer model | Description | Multilingual? |

+| :---------: | -------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- | :-----------: |

+| [GPT-2](https://huggingface.co/gpt2-xl) | Deși este antrenat ca un model lingvistic autoregresiv, puteți face GPT-2 să genereze rezumate prin adăugarea "TL;DR" la sfârșitul textului de intrare. | ❌ |

+| [PEGASUS](https://huggingface.co/google/pegasus-large) | Utilizează un obiectiv de preantrenare pentru a prezice propoziții mascate în texte cu mai multe propoziții. Acest obiectiv de preantrenare este mai apropiat de rezumare decât de vanilla language modeling și obține scoruri ridicate la standardele populare. | ❌ |

+| [T5](https://huggingface.co/t5-base) | O arhitectură Transformer universală care formulează toate sarcinile într-un framework text-text; de exemplu, formatul de intrare pentru modelul de rezumare a unui document este `summarize: ARTICOL`. | ❌ |

+| [mT5](https://huggingface.co/google/mt5-base) | O versiune multilingvă a T5, preantrenată pe corpusul multilingv Common Crawl (mC4), care acoperă 101 limbi. | ✅ |

+| [BART](https://huggingface.co/facebook/bart-base) | O nouă arhitectură Transformer cu un encoder și un stack de decodere antrenate pentru a reconstrui intrarea coruptă care combină schemele de preantrenare ale BERT și GPT-2. | ❌ |

+| [mBART-50](https://huggingface.co/facebook/mbart-large-50) | O versiune multilingvă a BART, preantrenată pe 50 de limbi. | ✅ |

+